���O�t���p�C�v�������Ă݂�

Unix/Linux �ɂ� ���O�t���p�C�v�Ƃ������̂�����܂��B

Unix�h���C���\�P�b�g�̐����Łu���O�t���p�C�v�ɗގ������@�\������`�v�Ə����Ă����� ���܂ʼn��ƂȂ��u�p�C�v�ɖ��O�t�����ȁv���炢�ɂƎv���Ă܂����� ���ۂɎg�������Ƃ��Ȃ������̂ŁA�����Ă݂܂��B

�g�p����̂� mkfifo �Ƃ����R�}���h�B

$ mkfifo /tmp/namedpipe

����ō쐬�����B

$ ls -l /tmp/namedpipe prw-rw-r-- 1 xxxxx xxxxx 0 Oct 22 22:06 /tmp/namedpipe

�Ȃł��Ă܂��� �����̐擪�� "p" �ɂȂ��Ă܂��B

�@�\�͂Ȃ�ƂȂ��z���ł��܂��ˁB

������m�F���邽�߂ɁA �܂��ʂ̃R���\�[���� ���̖��O�t���p�C�v�� tail ���܂��B

$ tail -f /tmp/namedpipe

�ҋ@��ԂɂȂ�܂����B

tail ���Ă���R���\�[���Ƃ͕ʂ̃R���\�[���� ���O�t���p�C�v�Ɍ������ă��_�C���N�g���Ă݂܂��B

$ echo test1 > /tmp/namedpipe $ echo test2 > /tmp/namedpipe

tail ���Ă���R���\�[������ �o�͂���Ă����܂��B

$ tail -f /tmp/namedpipe

test1

test2

�Ȃ�قǁA���ڂȂ����Ă��Ȃ��Ă� ���O�t���p�C�v��ʂ��ăf�[�^���A�g�ł��Ă܂��ˁB

rm �R�}���h�ō폜�ł��܂��B

$ rm /tmp/namedpipe

�����܂ł��ƁA�قڒʏ�̃t�@�C�����g���Ă������悤�Ȃ��Ƃ��ł��܂��� ���� tail ���Ă��Ȃ���ԂŃ��_�C���N�g����� �ʏ�̃t�@�C���Ƃ͈Ⴄ�����ɂȂ�܂����B

$ echo test3 > /tmp/namedpipe

���� ���O�t���p�C�v�� tail ���Ă��Ȃ��Ƃ��̏�Ԃ� ���_�C���N�g����� ���_�C���N�g���������ҋ@��ԂɂȂ�܂��B

���� ���O�t���p�C�v�� tail �� cat �Ȃǂ���� ���_�C���N�g���̑ҋ@����������܂��B

$ cat /tmp/namedpipe

test3

�֗��Ɏg����P�[�X�͂��肻���ł��ˁB

bash �� ��C���^���N�e�B�u���[�h �ł� alias �͎��s�ł��Ȃ�

������ƃn�}�肩�����̂Ń����B

bash �� �ualias ���g������֗��I�v�� �v�����������������̂� �g�����Ǝv������ł����g���܂���ł����B

[�Q�l]

�yBash�z �X�N���v�g����alias�R�}���h�����s�ł��Ȃ� - takafumi blog

��{�I�� �Θb���[�h����Ȃ��ƃ_���炵���ł��B

�m���� �ʂ̃R�}���h�� alias ����Ă�����댯�ł��ˁB

watch �R�}���h�ň��Ԋu�ŃR�}���h�����s����

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

watch �R�}���h�� �w�肵���R�}���h�����Ԋu�Ŏ��s���� �o�͌��ʂ̍�����\�����Ă���܂��� ���́u���Ԋu�ŃR�}���h�����s����v�Ƃ����@�\�� ���ꂾ���ŕ֗��ł��B

���̂悤�ɂ���� 3�b���Ƃ� Web�T�[�o�ɃA�N�Z�X���܂��B

$ watch -n 3 wget -q http://localhost/hogehoge -O - > /dev/null

�J��Ԃ������Ȃ� while �Ȃǂł��ł��܂��� ���Ԋu�Ŏ��s����Ȃ� watch �R�}���h���g���̂��ȒP�ŕ֗��ł��B

Linux �� �X�g�b�v�E�H�b�`�ɂ���

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

����ȏ����邩�ǂ����킩��܂��� Linux ���g���Ă��� �X�g�b�v�E�I�b�`���K�v�ɂȂ����ꍇ�̕��@�ł��B

$ time read

���ꂾ���ł��B

�R�}���h�̎��s�ŊJ�n�A [Enter] �������Ǝ��Ԃ��o�܂��B

$ time read

real 0m4.696s

user 0m0.000s

sys 0m0.000s

bash �� �I������ �ꎞ�t�@�C���������I�ɍ폜����

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

�V�F���X�N���v�g�ō쐬���� �ꎞ�t�@�C���� �I����Ɏ����I�ɏ����܂��B

�|�C���g�� 2�_����܂��B

�@�q�v���Z�X�ō쐬�����ꎞ�t�@�C���̃p�X�� �e�v���Z�X�Ŏ擾����̂� �V�F���X�N���v�g�ł͑�ςȂ̂ŁA �ꎞ�t�@�C���͍ŏ��ɋN�������V�F���X�N���v�g�� �쐬����f�B���N�g���̔z���Ɋi�[���܂��B

�A�ŏ��ɋN�������V�F���X�N���v�g�̏I������ builtin�R�}���h�� trap �� �ꎞ�t�@�C�����폜���鏈���ifunction�j�������I�Ɏ��s���܂��B

�܂��A�ꎞ�t�@�C���p�̃f�B���N�g�����쐬���܂��B

declare -r SCRIPT_PATH=${BASH_SOURCE:-$0}

declare -r SCRIPT_NAME=$(basename "${SCRIPT_PATH}")

declare -r SCRIPT_TMP_DIR=$(mktemp -d -t "${SCRIPT_NAME}.XXXXXX")

�����������Ƃ��ɒ������₷���悤�� �V�F���X�N���v�g�̖��O��t�����f�B���N�g�����쐬���܂��B

��L�̏ꍇ ���ϐ� TMPDIR �ɏ]���� ���̂悤�ȃf�B���N�g�����ɂȂ�܂��B �iTMPDIR �� /tmp�̏ꍇ�j

/tmp/hogehhoge.sh.mBzqNx

���̒l�� ���ϐ� TMPDIR �ɃZ�b�g���܂��B

export TMPDIR=${SCRIPT_TMP_DIR}

����� �q�v���Z�X�� function�Ȃǂ� �ꎞ�t�@�C�������ۂ� mktemp �� ���ϐ� TMPDIR ���g�p����I�v�V������t���Ă����� �����f�B���N�g���� �ꎞ�t�@�C�����쐬���邱�Ƃ��ł��܂��B

���� �����I�� �ꎞ�t�@�C�����폜����d�g�݂ł��B

�ꎞ�t�@�C�����폜���ďI������ function���`���܂��B

function on_exit_event() {

local script_exit_code=${1}

rm -Rf "${SCRIPT_TMP_DIR}"

exit ${script_exit_code}

}

rm�R�}���h�̃I�v�V������ "-f" ��t���ăt�@�C�����Ȃ��Ƃ����G���[���o�Ȃ��悤�ɂ��A "-R" �ŁA�t�@�C���ł͂Ȃ��A�ꎞ�f�B���N�g�����쐬�����ꍇ���폜�ł���悤�ɂ��܂��B

����� trap �ŋN������悤�ɂ��܂��B

trap 'on_exit_event ${?}' EXIT

����� �ꎞ�t�@�C���� �ŏ��ɋN�������V�F���X�N���v�g�̏I������ �����I�ɍ폜����܂��B

�S�͎̂��̂悤�ɂȂ�܂��B

#!/usr/bin/env bash

declare -r SCRIPT_PATH=${BASH_SOURCE:-$0}

declare -r SCRIPT_NAME=$(basename "${SCRIPT_PATH}")

declare -r SCRIPT_DIR=$(cd $(dirname "${SCRIPT_PATH}"); pwd)

declare -r SCRIPT_FULL_PATH=${SCRIPT_DIR}/${SCRIPT_NAME}

declare -r SCRIPT_TMP_DIR=$(mktemp -d -t "${SCRIPT_NAME}.XXXXXX")

export TMPDIR=${SCRIPT_TMP_DIR}

function on_exis_sub_event() { :; }

function on_exit_event() {

local script_exit_code=${1}

on_exis_sub_event

rm -Rf "${SCRIPT_TMP_DIR}"

exit ${script_exit_code}

}

trap 'on_exit_event ${?}' EXIT

�i�又���j

on_exis_sub_event�� �I�����̏�����lj��������Ȃ����ꍇ�� �㏑�����邽�߂� function�ł��B �Ƃ肠���� ��Œ�`���Ă����� �K�v�ɉ����� ��ōĒ�`���܂��B

bash �� ":"(�R����) �́Abuiltin command

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

bash �̃V�F���X�N���v�g��ǂ�ł���� �Ƃ��ǂ� ":" (�R����) ���o�ꂵ�܂��B ���� ":" �� bash �� builtin �ł��B

���s����ƁA�A�A

$ :

�����Ԃ��Ă��܂��� �G���[���o�܂���B

���Ȃ݂� ";"(�Z�~�R����) ���� ���̂悤�ɃG���[���o�܂��B

$ ;

-bash: syntax error near unexpected token `;'

type �R�}���h�Ō���� builtin �ƂȂ��Ă܂��B

$ type :

: is a shell builtin

���̂悤�ɃR�����g�Ƃ��Ďg�����Ƃ��ł��܂��B

: comment comment : comment comment : comment comment

�R�}���h�v�����v�g�� REM �Ɠ����ł��ˁB

�����Ԃ��Ȃ��̂� ���̂悤�ɂ��� ��t�@�C�����쐬���邱�Ƃ��ł��܂��B

$ : > blank.log

�v���Z�X�u���Ƒg�ݍ��킹�� ���̂悤�ɂ��ċ�t�@�C�����쐬���邱�Ƃ��ł��܂��B

$ cat <(:)> blank.log

�m���Ă���Γǂ߂܂��� �m��Ȃ��ƋL���ɂ��������܂���B

bash �� �v���Z�X�u��

script �R�}���h���g�������Z�ł��B

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

bash �ɂ� �u�v���Z�X�u���v�Ƃ����@�\������܂��B

Process Substitution

Process substitution is supported on systems that support named pipes (FIFOs) or the /dev/fd method of naming

open files. It takes the form of <(list) or >(list). The process list is run with its input or output con�]

nected to a FIFO or some file in /dev/fd. The name of this file is passed as an argument to the current com�]

mand as the result of the expansion. If the >(list) form is used, writing to the file will provide input for

list. If the <(list) form is used, the file passed as an argument should be read to obtain the output of

list.

When available, process substitution is performed simultaneously with parameter and variable expansion, com�]

mand substitution, and arithmetic expansion.

�������̈ꎞ�t�@�C���̍쐬�����点��@�\�ŁA �����Ă����̕��@�ő�p�͌����̂ł��� �ǂ������Ŏg���ƃR�}���h���ǂ݂₷���Ȃ����肵�܂��B

�������́A���� 2�B

<(�R�}���h)

>(�R�}���h)

���O�̎��Ă�u�R�}���h�u���v�Ə����������Ă܂��ˁB

�R�}���h�u���ƃv���Z�X�u��

$(�R�}���h) #�R�}���h�u��

�u�R�}���h�u���v�́A�R�}���h�̌��ʂ� �R�}���h��R�}���h�̈����Ƃ��Ďg�p���邱�Ƃ��ł��܂����B

$ echo $(echo date) date

$ $(echo date) Thu Dec 8 22:58:19 JST 2018

�u�v���Z�X�u���v�́A�R�}���h�̌��ʂ� �t�@�C���̓��͂̂悤�Ɉ������� �o�͂��R�}���h�ɓn������ł��܂��B

<(�R�}���h)

�܂��� "<(�R�}���h)" �̕��ł����A�R�}���h�œ��̓t�@�C���̃p�X�� �w�肷��Ƃ���ɏ������Ƃ��ł��܂��B

�悭�g�����Ƃ��Ă�

diff �R�}���h�ł��B

diff �R�}���h�́A2�̃t�@�C�����r����ۂ�

�W���o�͂� 1�����w��ł��Ȃ�����

2�̃R�}���h�̎��s���ʂ��r�������ꍇ

��r����R�}���h�̕Е��͎��̂��K�v�ɂȂ�܂��B

$ ls -l /var/xxxx > xxxx.txt $ ls -l /var/yyyy > yyyy.txt $ diff xxxx.txt yyyy.txt

$ ls -l /var/xxxx > xxxx.txt $ ls -l /var/yyyy | diff - xxxx.txt

�u�v���Z�X�u���v���g���� �ꎞ�t�@�C�����쐬������ 2�̃R�}���h�̎��s���ʂ� ���̂܂ܔ�r���邱�Ƃ��ł��܂��B

$ diff <(ls -l /var/xxxx) <(ls -l /var/yyyy)

�R�}���h�����₷���ł��ˁB

�ꎞ�t�@�C�����폜�����Ԃ��Ȃ��Ȃ�܂��B

echo �ŏo�͂���� �u�v���Z�X�u���v�̎��̂� �t�@�C���f�X�N���v�^���Ƃ킩��܂��B

$ echo <(echo 1)

/dev/fd/63

�킩��ɂ����Ȃ�܂��� ���̂悤�Ȃ��Ƃ��ł��܂��B

$ $(cat <(echo date))

Thu Dec 8 22:14:36 JST 2018

����� �܂� ���̂悤�ɏ�������� "date" ���Ԃ��Ă��܂��B

$ echo date > /dev/fd/63 $ cat /dev/fd/63

�Ԃ��Ă��� date �����s���� �������o�͂���܂����B

$ date

Thu Dec 8 22:14:36 JST 2018

�܂� ���̂悤�� do ... done �̃��[�v�� �p�C�v�łȂ��� ���̏������ʃv���Z�X�ɂȂ� ���ϐ��� �㏑�����Ă���Ȃ��悤�ȏꍇ�A�A�A

$ filename=none $ ls | grep -v "test." | while read filepath > do > filename=$(basename $filepath) > done $ echo $filename none #���ʃv���Z�X�̂��ߏ㏑������Ȃ�

�u�v���Z�X�u���v���g���� �t�@�C�����w�肷��̂Ɠ����悤�� �����v���Z�X�ŏ������邱�Ƃ��ł��܂��B

$ filename=none $ while read filepath > do > filename=$(basename $filepath) > done < <(ls | grep -v "test.") $ echo $filename xxxxx.txt #�������v���Z�X�̂��ߏ㏑�����ꂽ

>(�R�}���h)

���� ">(�R�}���h)" �̕��ł����A������� ���������p�C�v�łł��Ă��܂����� ���܂�ǂ��Ⴊ�v�������т܂���ł����B

�悭�g���͎̂��̂悤�� �W���G���[�o�͂� �s�v�ȍs���I�~�b�g����P�[�X���ł��B

$ command 2> >(grep -v ^Notice: >&2)

����́A�W���G���[�o�͂���U �v���Z�X�u���� grep �R�}���h�ɓn���� "Notice:" ���� �n�܂�s���Ȃ��āA�ēx�W���G���[�o�͂ɓn���Ă��܂��B

���ɂ� tee �R�}���h�Ƒg�ݍ��킹�� ����̏o�͂����U�蕪���� �Ȃ�Ă��Ƃ��ł��܂��B

$ cat test.txt | \ > tee >(grep ^case1 > case1.txt) \ > tee >(grep ^case2 > case2.txt) \ > tee >(grep ^case3 > case3.txt) \ > > /dev/null

���̗�ł́A�o�͂��ꂽ�s�̐擪�̕����ɂ���� �ʂ̃t�@�C���ɕۑ����Ă��܂��B

script �R�}���h�ŁA�ʂ̒[���̑�������j�^�����O����

script �R�}���h���g�������Z�ł��B

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

script �R�}���h�� ��Ƃ̃��O���Ƃ��Ă����֗��ȃR�}���h�ł��� ���̃R�}���h�𗘗p����� �ʂ̒[���̑�������j�^�����O���邱�Ƃ��ł��܂��B

�[�� A

���삷�鑤�� �[�� A �ł́A

script �R�}���h��

"-f" �I�v�V�����t���Ŏ��s���܂��B

$ script -f /tmp/test.log

-f, --flush run flush after each write

"-f" �� �����Ƀ��O�ɏo�͂��邽�߂̃I�v�V������ �ڑ����ꂽ�ꍇ�ɂ����S�̃I�v�V�����ł��B

�[�� B

���j�^�����O���鑤�� �[�� B �ł́A

tail �R�}���h��

"-f" �I�v�V�����t����

���s���A

�[�� A ��

script �R�}���h�̃��O���Q�Ƃ��܂��B

$ tail -f /tmp/test.log

���̏�Ԃ� �[�� A �ő��������� �[�� B �̃R���\�[���ɂ��������e���o�͂���܂��B

�_�u���`�F�b�N�� �w������ꍇ�Ȃǂɕ֗����Ǝv���܂��B

�� �ԈႦ�� "script -f" �����s���� �[�� A �� script �R�}���h�� ���O�t�@�C���� "tail -f" �ŊJ���Ă��܂��� �������[�v�ɓ����Ă��܂��̂Œ��ӂ��Ă��������B

�����t�@�C�������� tar �R�}���h�Ōł߂�

�����ł��B

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

find �R�}���h�Ŏ擾�����X�V�����V�����t�@�C�������� tar �R�}���h�� �ł߂���@�ł��B

�X�V���́A��r�Ώۂ̃t�@�C�����V�������̂��擾���܂��B �i���̕��@�ɂ��ẮA�O�ɏ����Ă����̂ŁA��������Q�Ƃ��Ă��������j

�܂��͊��ϐ��̐ݒ�B

��r�Ώۂ̃t�@�C���iBASE_FILE_PATH�j��

�ł߂�TAR�t�@�C���iTAR_FILE_PATH�j�̃p�X��ݒ肵�܂��B

$ BASE_FILE_PATH=./last_update.txt $ TAR_FILE_PATH=/tmp/xxxxxx

������TAR�t�@�C�������݂���Ƃ�낵���Ȃ����� �O�̂��߂ł����A0�o�C�g�ŏ㏑�����Ă����܂��B

$ cat /dev/null > ${TAR_FILE_PATH}.tar

find �R�}���h�Ńt�@�C�����擾���� tar �R�}���h�Ōł߂܂��B ���̂Ƃ��Atar �R�}���h�ł� �NjL "r" ���w�肷��̂� ���k�� "z" �͎w�肵�Ȃ��悤�ɂ��܂��B

$ find ./ -type f -newer ${BASE_FILE_PATH} -exec tar rf ${TAR_FILE_PATH}.tar {} \;

TAR �{�[�����������ň��k���܂��B

$ gzip -f ${TAR_FILE_PATH}.tar

�Ō�ɔ�r�Ώۂ̃t�@�C���� touch �R�}���h�ōX�V���Ă����� �������̌ォ��̍������擾���邱�Ƃ��ł��܂��B

$ touch ${BASE_FILE_PATH}

find �R�}���h�œ������w�肵�Č��o����

�����ł��B

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

find �R�}���h�� -mtime �I�v�V�������g���� �t�@�C���̍X�V���������ɂ��āu�`���O�v�̂悤�Ȍ��o���ł��܂��B

$ find ./ -mtime -3

��̓I�ɓ������w�肵�Č��o����ɂ� ���̂悤�� -newermt �I�v�V�������g�p���܂��B �i-newermt �� m �� Modify �� m �ŁAa �ɂ���� Access�Ac ���� Change �ɂȂ�܂��j

$ find ./ -newermt "2018/10/30 12:00"

�i���t�̏����͐F�X�w��ł��܂��j

����Ŏw�肵�����������^�C���X�^���v���傫���i�w�肵�������͊܂܂�Ȃ��j�t�@�C�������o���邱�Ƃ��ł��܂��B

-newerXY reference

Compares the timestamp of the current file with reference. The reference argument is normally the name

of a file (and one of its timestamps is used for the comparison) but it may also be a string describing

an absolute time. X and Y are placeholders for other letters, and these letters select which time

belonging to how reference is used for the comparison.

a The access time of the file reference

B The birth time of the file reference

c The inode status change time of reference

m The modification time of the file reference

t reference is interpreted directly as a time

Some combinations are invalid; for example, it is invalid for X to be t. Some combinations are not

implemented on all systems; for example B is not supported on all systems. If an invalid or unsup�]

ported combination of XY is specified, a fatal error results. Time specifications are interpreted as

for the argument to the -d option of GNU date. If you try to use the birth time of a reference file,

and the birth time cannot be determined, a fatal error message results. If you specify a test which

refers to the birth time of files being examined, this test will fail for any files where the birth

time is unknown.

find �R�}���h�œ���̃t�@�C���ȍ~�̍X�V�����o����

�����ł��B

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

find �R�}���h�� -mtime �I�v�V�������g���� �t�@�C���̍X�V���������ɂ��āu�`���O�v�̂悤�Ȍ��o���ł��܂��B

$ find ./ -mtime -3

�����̍�ƂōX�V�����t�@�C���ȍ~�ɍ쐬�E�X�V���ꂽ�t�@�C�������o�������ꍇ -newer �Ƃ����I�v�V�������g���܂��B

$ find ./ -newer hogehoge.txt

-newer file

File was modified more recently than file. If file is a symbolic link and the -H option or the -L

option is in effect, the modification time of the file it points to is always used.

���̃I�v�V�����́A�����̃t�@�C���̃^�C���X�^���v���^�C���X�^���v���V�����t�@�C�������o���Ă���܂��B

�����̃t�@�C���̃^�C���X�^���v�g���傫���h���߁A���̃t�@�C�����̂͊܂܂�܂���B �����̃t�@�C�����Ώۂ̒��ɂ����Ă��A���o����Ȃ��悤�ɂȂ��Ă�킯�ł��B �悭�l�����Ă܂��ˁB

tar �R�}���h�Ńp�X��ύX���ēW�J������

�����ł��B

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

tar �R�}���h�œW�J����Ƃ��� �i�[����Ă���p�X�����̂܂g������ �p�X�̈ꕔ��ύX���ēW�J�������Ƃ�������܂��B

[�i�[�������p�X] home/hogehoge/test1/xxxxxx [�W�J�������p�X] /home/hogehoge/test2/xxxxxx

���̂悤�ɃI�v�V�����ƕύX���e���w�肷�邱�ƂŁA �p�X��ύX���Ȃ���W�J���邱�Ƃ��ł��܂��B

$tar xzvf xxxxx.tar.gz --transform='s/test1/test2/g'

File name transformations:

--transform=EXPRESSION, --xform=EXPRESSION

use sed replace EXPRESSION to transform file

names

�f�B���N�g���́u / �v���ύX�������ꍇ�� ���̂悤�ɋ�蕶�����u | �v�ȂǂɕύX���Ă����Ɨǂ��Ǝv���܂��B

$tar xzvf xxxxx.tar.gz --transform='s|hogehoge/test1|hugahuga/test2|g'

tar �R�}���h�ňꕔ������W�J������

�����ł��B

�i�g���Ă��� Linux �� Ubuntu 14.04.3 LTS �ł��j

tar �R�}���h�œW�J����Ƃ��� ����̃t�@�C����A����̃f�B���N�g���ȉ��̃t�@�C��������W�J�������Ƃ�������܂��B

���̂悤�Ƀp�X���w�肷�邱�ƂŁA���̃t�@�C��������W�J���邱�Ƃ��ł��܂��B

$ tar xvzf xxxxx.tar.gz home/hogehoge/test.html

���l�ɁA�f�B���N�g���̃p�X���w�肷��ƁA���̃f�B���N�g���ȉ���W�J�ł��܂��B

$ tar xvzf xxxxx.tar.gz home/hogehoge

�p�X�̎w��ɂ̓��C���h�J�[�h���g�����Ƃ��ł��܂��B

$ tar xvzf xxxxx.tar.gz --wildcards */hogehoge.png

File name matching options (affect both exclude and include patterns):

--wildcards use wildcards (default for exclusion)

--no-wildcards verbatim string matching

�]�k�ł����ATAB�L�[�̓��͕⊮�� .tar.gz �t�@�C���̒��̃p�X�܂� �w��ł��ăr�b�N�����܂����B

Bash �̃G���[�������ɏI������I�v�V����

�ʏ�ABash �̏����� �G���[���������Ă����̃X�e�b�v�ւ� �i��ōs���܂��B

[test1.sh]

true

echo 1=$?

false

echo 2=$?

true

echo 3=$?

false

echo 4=$?

$ bash test1.sh

1=0

2=1

3=0

4=1

�G���[�����������Ƃ��Ɏ~�߂�ɂ� �I�v�V���� "-e" ��t���܂��B

$ bash -e test1.sh 1=0

�܂��A�p�C�v���Ă���ꍇ �Ō�̃R�}���h�̌��ʂ��Ԃ�܂��B

[test2.sh]

true | true

echo 1=$?

true | false | true

echo 2=$?

false | true

echo 3=$?

true | false

echo 4=$?

$ bash test2.sh

1=0

2=0

3=0

4=1

����ɃI�v�V���� "-e" ��t���Ď��s���Ă�

$ bash -e test1.sh 1=0 2=0 3=0

�Ō�̃R�}���h�Ŕ������Ă���G���[���� �������Ă���܂���B

���̂悤�ȂƂ��� ����� �I�v�V���� "-o pipefail" ���w�肵�܂��B

$ bash -e -o pipefail test1.sh 1=0

����Ńp�C�v���̃G���[���Ԃ�悤�ɂȂ�܂��B

Bash �̖���`�̕ϐ����`�F�b�N����I�v�V����

Bash �ɂ� �v���O��������̂悤�� ����`�̕ϐ����`�F�b�N�ł��� �I�v�V���� "-u" ������܂��B

���̃I�v�V�������w�肵�Ă���� ����`�̕ϐ����o�Ă����Ƃ���� �G���[�ɂ��Ă���܂��B

�����Ă݂܂��B

[test.sb]

A=a

C=c

echo A=$A

echo B=$B

echo C=$C

�܂��͕��ʂɎ��s�B

$ bash test.sh A=a B= C=c $ echo $? 0

�ϐ� B ������`����Ă��Ȃ��̂Œl����ł��B

���ɃI�v�V������t���Ď��s�B

$ bash -u test.sh A=a test.sh: line 4: B: unbound variable $ echo $? 1

�r���ŃG���[�ɂȂ�܂����B ���S�ł��ˁB

���̃I�v�V�������l set �R�}���h�Ȃǂł��w��ł��܂��B

Bash �̎��s���e�̃g���[�X�̃I�v�V����

Bash �ɂ� �����̎��s���e���g���[�X�ł��� �f�o�b�O�ɕ֗��� �I�v�V���� "-x" �� "-v" ������܂��B

���@�`�F�b�N�� "-n" �Ɠ����l�� �F�X�ȕ��@�Ŏw��ł��܂��B

$ bash -xv test.sh

#!/bin/bash -xv

set -xv

���Ȃ݂ɁA�I�v�V���� "-x" �͎��s���ꂽ���e���o�͂� �I�v�V���� "-v" �͎��s����ȃR�}���h���o�͂��܂��B

���̃V�F���X�N���v�g�Ŏ����Ă݂܂��B

[test.sh]

YESTERDAY=$(date --date "1 day ago")

echo $YESTERDAY

�܂����ʂɎ��s�B

$ bash test.sh

Sun Oct 1 21:55:13 JST 2017

�܂� �I�v�V���� "-x" �������w��B

$ bash -x test.sh ++ date --date '1 day ago' + YESTERDAY='Sun Oct 1 21:55:23 JST 2017' + echo Sun Oct 1 21:55:23 JST 2017 Sun Oct 1 21:55:23 JST 2017

�lj��ŏo�͂��ꂽ�s�̐擪�� "+" �� "++" ���t���Ă܂��B

"++" �� "$()" �Ŏ��s���ꂽ�����ł��ˁB

�ϐ����l�ɓ]������Ă��܂��B

���� �I�v�V���� "-v" �������w��B

$ bash -v test.sh YESTERDAY=$(date --date "1 day ago") date --date "1 day ago" echo $YESTERDAY Sun Oct 1 21:55:28 JST 2017

������� "+" �Ȃǂ͕t�����A�ϐ������̂܂܂ł��ˁB

"$()" �̎��s���肾����Ă��܂��B

����� �I�v�V���� "-x" "-v" �𗼕��w��B

$ bash -xv test.sh YESTERDAY=$(date --date "1 day ago") date --date "1 day ago" ++ date --date '1 day ago' + YESTERDAY='Sun Oct 1 21:55:44 JST 2017' echo $YESTERDAY + echo Sun Oct 1 21:55:44 JST 2017 Sun Oct 1 21:55:44 JST 2017

���s����R�}���h�A���s���e���S�ďo�͂���܂����B

�܂� �I�v�V���� "-x" "-v" �̎w����������ɂ� �I�v�V���� "+x" "+v" ���w�肵�܂��B

$ set -x $ YESTERDAY=$(date --date "1 day ago") ++ date --date '1 day ago' + YESTERDAY='Sun Oct 1 22:06:42 JST 2017' $ echo $YESTERDAY + echo Sun Oct 1 22:06:42 JST 2017 Sun Oct 1 22:06:42 JST 2017 $ set +x + set +x $ YESTERDAY=$(date --date "1 day ago") $ echo $YESTERDAY Sun Oct 1 22:06:57 JST 2017 $ set -v $ YESTERDAY=$(date --date "1 day ago") YESTERDAY=$(date --date "1 day ago") date --date "1 day ago" $ echo $YESTERDAY echo $YESTERDAY Sun Oct 1 22:07:09 JST 2017 $ set +v set +v $ YESTERDAY=$(date --date "1 day ago") $ echo $YESTERDAY Sun Oct 1 22:07:20 JST 2017

���@�`�F�b�N�̃I�v�V���� "-n" �� "-v" ��g�ݍ��킹��� ���s�����ɁA���s���e�������m�F���邱�Ƃ��ł��܂��B

$ bash -nv test.sh YESTERDAY=$(date --date "1 day ago") echo $YESTERDAY

Bash �� ���@�`�F�b�N�̃I�v�V����

Bash �ɂ� ���������s������ ���@�̃`�F�b�N���������Ă����I�v�V���� "-n" ������܂��B

[test.sh]

if [ -z test.txt ]; then

echo "OK"

endif

$ bash -n test.sh test.sh: line 4: syntax error: unexpected end of file

���̃I�v�V������t���邱�Ƃ�

�R�}���h�����s������

���@�������`�F�b�N���Ă���܂��B

�i�t�ɃR�}���h�̎��s�Ȃǂ̓`�F�b�N�ł��܂���j

���̎�� Bash �̃I�v�V�����̎w����@�� ����������܂��B

�@bash �R�}���h�̈������Ɏw�肷��B

$ bash -n test.sh

�A�X�N���v�g�̐擪�ɋL�ڂ���B

#!/bin/bash -n

�Bset �R�}���h�Ŏw�肷��B

set -n

�X�N���v�g�̋N���������m�F�������Ƃ��Ȃ� �F�X�Ɖ��p�ł��܂��B

Bash �Ń��[�v��ʃv���Z�X�ɂ��Ȃ�

Bash �ňȉ��̂悤�ȃ��[�v������������ �p�C�v�ȍ~���ʃv���Z�X�ɂȂ��Ă��܂����� ���̒��Őݒ肵���ϐ����A���[�v�����̊O�ŎQ�Ƃ��邱�Ƃ��ł��܂���B

cat test1.txt | while read val1 val2

do

val3=$val1

done

echo $val3 # ���Ō��val1�͓����Ă��Ȃ�

�P���Ƀe�L�X�g����ǂݍ��ޏꍇ ���̂悤�ɏ����� �ʃv���Z�X����炸�ɍςނ��� ���[�v�̒��Őݒ肵���ϐ��� ���[�v�̊O�ŎQ�Ƃ��邱�Ƃ��ł��܂��B

while read val1 val2

do

val3=$val1

done < test1.txt

echo $val3 # ���Ō��val1�������Ă���

�R�}���h�̎��s���ʂ����[�v�� �n���Ă���ꍇ���E�E�E

cat test1.txt | grep -v "^a" | while read val1 val2 do val3=$val1 done echo $val3 # ���Ō��val1�͓����Ă��Ȃ�

���悤�ȏ����������邱�Ƃ��ł��܂��B

while read val1 val2

do

val3=$val1

done < <(cat test1.txt | grep -v "^a")

echo $val3 # ���Ō��val1�������Ă���

�i "<" �̌�̋ɒ��ӂ��Ă��������j

�v���O�����I�ȏ������K�v�ȂƂ��� ������܂��B

Linux �Ńv���Z�X�̊��ϐ����m�F����

�ȑO�APostgreSQL �̃p�X���[�h��

���ϐ��Őݒ肷��L���������܂�����

PostgreSQL �I�ɂ͔��̂悤�ł��B

�i�ꕔ�̃I�y���[�e�B���O�V�X�e���ł�root�ȊO�̃��[�U�Ŋ��ϐ���������ꍇ���邽�߂Ƃ̂��Ɓj

[�Q�l]

���ϐ� - PostgreSQL 9.3.2����

�ꕔ�̃I�y���[�e�B���O�V�X�e�����ǂ���w���̂��킩��܂��A �v���Z�X���g���Ă���ϐ��̌������C�ɂȂ����̂� ������Ɗm�F���Ă݂܂����B

�܂����ϐ���ݒ肵�܂��B

$ export PGPASSWORD=testpassword

PostgreSQL �̃f�[�^�x�[�X�ɐڑ�����v���Z�X���쐬���܂��B

$ psql -U testuser -d testdb

psql (9.3.10, server 9.3.12)

Type "help" for help.

testdb=#

[Ctrl]+[z] �v���Z�X�点�܂��B

[1]+ Stopped psql -U testuser -d testdb

�N�����̃v���Z�X���m�F���܂��B

$ ps PID TTY TIME CMD 28796 pts/0 00:00:00 bash 29754 pts/0 00:00:00 psql 29834 pts/0 00:00:00 ps

�Q�l�T�C�g�ɂ��ƁA���ϐ��́u/proc/%{PID}/environ�v�� �i�[����Ă��邻���ł��B

[�Q�l]

Linux/Unix�v���Z�X�N�����̊��ϐ����_���v���� | �M�[�N��ڎw����

�m�F���Ă݂܂��B

$ cat /proc/29754/environ | sed -e 's/\x0/\n/g' | grep PGPASSWORD PGPASSWORD=testpassword

�������Ɋm�F�ł��܂����B

�g�p���Ă�����ł� root ���[�U�łȂ���� �����ȊO�̊��ϐ��͌���܂���ł������A �����̊��ϐ����iroot�̌������g����A���̃v���Z�X�̊��ϐ����j�m�F���������Ƃ�����Ǝv���̂� �o���Ă����Ɨǂ��̂�������܂���B

���C���h�J�[�h�œ���̃t�@�C�����������O����

�ʏ�A���C���h�J�[�h���g���� �ȉ��̂悤�ɂȂ�Ƃ�����E�E�E�B

$ ls -1 *.txt

1-1.txt

1-2.txt

2-1.txt

2-2.txt

3-1.txt

"!" ���g�����ƂŁA�t�ɏ��O���邱�Ƃ��ł��܂��B

$ ls -1 !(*-2.txt)

1-1.txt

2-1.txt

3-1.txt

���̗�ł́u*-2.txt�v�Ƀ}�b�`���Ȃ��t�@�C���� �\������܂����B

tail �R�}���h�Ńt�@�C�����č쐬����Ă��ǂ�������

tail �R�}���h�� "-f" �I�v�V������ "--follow=descriptor" �Ƃ������Ƃ� �Ώۂ̃t�@�C�����č쐬�����ƒǂ��������Ȃ��Ȃ�܂��B

$ tail -f test.txt

���������Ƃ��́A"--follow=name" �� "-F" ���g���܂��B

$ tail -F test.txt

-f, --follow[={name|descriptor}]

output appended data as the file grows;

-f, --follow, and --follow=descriptor are

equivalent

-F same as --follow=name --retry

$ tail -F test.txt Fri Sep 9 12:14:01 JST 2017 Fri Sep 9 12:14:02 JST 2017 tail: 'test.txt' has become inaccessible: No such file or directory tail: 'test.txt' has appeared; following end of new file Fri Sep 9 12:14:12 JST 2017 Fri Sep 9 12:14:13 JST 2017

���Ȃ݂� �t�@�C�����č쐬�����Ə�̂悤�ɕ\������܂��B

Linux �̃p�X��W�J���� glob

�t�@�C����f�B���N�g���𑀍삷��Ƃ��� "*" �� "?" �Ȃǂ̃��C���h�J�[�h���g���܂��� ���ꂪ���ɂ���Ē�`����Ă���̂��� �l�������Ƃ�����܂���ł����B

����A Linux �ł� glob �Ƃ������O�������ł��B

[�Q�l]

Dev Basics�^Keyword�Fglob�i�O���u�j - ��IT

�L����ǂ�ŋ������̂� Linux �ł͕����N���X�i[0-9a-z]�݂����Ȃ�j���g����Ƃ̂��ƁB Windows �̃R�}���h�v�����v�g�ł͎g���Ȃ����� ���C���h�J�[�h�������Ǝv������ł܂����B

$ ls -1 /var/log/vsftpd.log* /var/log/vsftpd.log /var/log/vsftpd.log.1 /var/log/vsftpd.log.2 /var/log/vsftpd.log.3 /var/log/vsftpd.log.4 $ ls -1 /var/log/vsftpd.log.? /var/log/vsftpd.log.1 /var/log/vsftpd.log.2 /var/log/vsftpd.log.3 /var/log/vsftpd.log.4 $ ls -1 /var/log/vsftpd.log.[2-3] /var/log/vsftpd.log.2 /var/log/vsftpd.log.3 $ ls -1 /var/log/vsftpd.log.[^3-5] /var/log/vsftpd.log.1 /var/log/vsftpd.log.2

���[��A����͕֗��B

���������͓̂�����O�߂��āA �m���Ă�l�́u���̐l���m���Ă�v�Ǝv���� �킴�킴�`���Ȃ����̂Ȃ̂�������Ȃ��ł��ˁB

���Ȃ݂ɁA�t�@�C�����R�s�[����Ƃ��ɂ悭�g�� {} �̓W�J�� glob �̎d���������ł��B

$ ls -1 /var/log/syslog* /var/log/syslog $ cp -p /var/log/syslog{,.keep} $ ls -1 /var/log/syslog* /var/log/syslog /var/log/syslog.keep

find �̓��t�����̊����

find �� "-mtime" �Ȃǂ̓��t������ �I�v�V�����͕֗��ł��� �R�}���h�̎��s�������_�� ������i��������24���Ԉȓ��Ȃǁj�ɂȂ邽�� ��₱���������肷�邱�Ƃ�����܂��B

�P�[�X�ɂ����܂����A

���t������

�֗��ȃI�v�V������

"-daystart" ������܂��B

�g�����͊ȒP�B�t���邾���B

$ find . -daystart -mtime -3

"-daystart" �� "-mtime" �Ȃǂ���ɏ����܂��B

���̃I�v�V�����ŁA���t�����̊��00��00���ɂȂ邽�� ���ݎ����ł͂Ȃ��A���t�P�ʂōl���邱�Ƃ��ł���悤�ɂȂ�܂��B

date �R�}���h�ŁA���t�̏����ϊ�

���l�^�B

$ date -d "2017/3/4 1:15" +"%Y/%m/%d %H:%M"

2017/03/04 01:15

date �R�}���h�� ���t�������^���� �o�͂̏������w�肷��A������0�l�߂��ȒP�B

Linux �����̌��̃h�b�g�ɂ���

Redhat7.2��G���Ă��āA����H�Ǝv���܂����B

$ ls -l -rw-r--r--. 1 root root 108 9�� 25 2015 xxxxxxxxxxx

ls ����ƁA�����̌��Ƀh�b�g���t���Ă��܂����B

���ׂĂ݂�ƁA���̃h�b�g�́uSELinux�̃Z�L�����e�B�R���e�L�X�g���ݒ肳��Ă����v�Ƃ̂��ƁB

[�Q�l]

RHEL6�ŁAls -l �ł������Ɍ����̌���".�i�h�b�g�j"���t���A�t���Ȃ��͉����Ӗ����Ă�H - Qiita

ls �� "-Z" �t���Ă݂�ƁA�Z�L�����e�B�R���e�L�X�g���\�������悤�ł��B

-Z, --context Display security context so it fits on most

displays. Displays only mode, user, group,

security context and file name.

$ ls -Z -rw-r--r--. root root system_x:object_x:system_xxxx:s0 xxxxxxxxxxx

�F�X�ƒm��Ȃ����Ƃ�������Ȃ��A�Ƃ����b�B

test �R�}���h�� -v �I�v�V����

Bash �V�F�������s����Ƃ��� ���ϐ��̐ݒ�̗L�����m�F���Ă���̂ł��� ��{������Ȃ̂ŁA�p�b�ƌ���������Ղ� ���̂悤�ȏ��������悭���Ă��܂����B

if [ "${VAR_XXXXX}" = "" ]; then

echo "���ϐ������ݒ�"

�l���K�{�������̂ŁA�ǂ������̂ł��� ���܂��ܔz����g�����ƂɂȂ�A ����������������Ɩ��ݒ�Ƀ}�b�`���Ă��܂��܂����B

���ׂĂ݂�ƍŋ߂� test �R�}���h�� -v �I�v�V���������� �ϐ��̒�`�̗L�����`�F�b�N�ł���Ƃ��B

if [ ! -v VAR_XXXXX ]; then echo "���ϐ������ݒ�"

����ŃC�P�܂����B

�܂����͑I�Ԃ悤�ł����A�����ڂ��킩��₷���ėǂ��ł��ˁB

Ubuntu14.04 �ŁAsendmail �̃I�v�V�������g���Ȃ��Ȃ��Ă��b

�O���ɑ����AUbuntu14.04 �����ł��B

Ubuntu10.04 �ł́A�ȉ��̂悤�� mail �R�}���h�� sendmail �̃I�v�V�������g�p�ł��Ă��܂����B

MAIL(1) BSD General Commands Manual MAIL(1)

NAME

mail, mailx, Mail �\ send and receive mail

SYNOPSIS

mail [-dEIinv] [-a header] [-b bcc-addr] [-c cc-addr] [-s subject] to-addr ... [-- sendmail-options ...]

mail [-dEIiNnv] -f [file]

mail [-dEIiNnv] [-u user]

�n�C�t�� 2 �t���Ĉȉ��̂悤�ɂ��Ă��܂����B

$ mail -s "subject" to@xxx -- -f from@xxx

Ubuntu14.04 �ł́Asendmail �̃I�v�V������ �w��ł��Ȃ��Ȃ��Ă��܂����B �i�w�肷��ƁA���M��̃A�h���X�Ɣ��肳��Ă��܂��܂��j

MAILX(1) User Commands MAILX(1)

NAME

mailx - send and receive Internet mail

SYNOPSIS

mailx [-BDdEFintv~] [-s subject] [-a attachment ] [-c cc-addr] [-b bcc-addr] [-r from-addr] [-h hops]

[-A account] [-S variable[=value]] to-addr . . .

mailx [-BDdeEHiInNRv~] [-T name] [-A account] [-S variable[=value]] -f [name]

mailx [-BDdeEinNRv~] [-A account] [-S variable[=value]] [-u user]

�O���̘b�̂悤�� bsd-mailx ���� heirloom-mailx �� �ւ�������炩�Ǝv�� mail �R�}���h�� bsd-mailx �ɖ߂��Ă݂܂����B

$ sudo update-alternatives --config mailx

There are 3 choices for the alternative mailx (providing /usr/bin/mailx).

Selection Path Priority Status

------------------------------------------------------------

* 0 /usr/bin/heirloom-mailx 60 auto mode

1 /usr/bin/bsd-mailx 50 manual mode

2 /usr/bin/heirloom-mailx 60 manual mode

3 /usr/bin/mail.mailutils 30 manual mode

Press enter to keep the current choice[*], or type selection number: 1

update-alternatives: using /usr/bin/bsd-mailx to provide /usr/bin/mailx (mailx) in manual mode

������ ��͂�Asendmail �̃I�v�V������ �Ȃ��Ȃ��Ă��܂����B

MAIL(1) BSD General Commands Manual MAIL(1)

NAME

mail, mailx, Mail �\ send and receive mail

SYNOPSIS

mail [-dEIinv] [-a header] [-b bcc-addr] [-c cc-addr] [-s subject] to-addr ...

mail [-dEIiNnv] -f [file]

mail [-dEIiNnv] [-u user]

���Ȃ݂� Ubuntu14.04 �� heirloom-mailx �ł́A���M���͈ȉ��̂悤�Ɏw�肵�܂��B

$ mail -s "subject" -r from@xxx to@xxx

Ubuntu14.04 �ŁA�W�����[���� heirloom-mailx �ɂȂ��Ă��b

Ubuntu14.04 �ł̘b�ł��B

mail �R�}���h�̃V���{���b�N�����N��ǂ��Ă����܂��B

$ readlink -f `which mail` /usr/bin/heirloom-mailx

heirloom-mailx �ł��B

Ubuntu10.04 �ł́Absd-mailx �ł����B

$ readlink -f `which mail` /usr/bin/bsd-mailx

�����̃��[���p�b�P�[�W�����Ă���ꍇ�� update-alternatives �R�}���h�� ��ւ��邱�Ƃ��ł��܂��B

$ sudo update-alternatives --config mailx There are 3 choices for the alternative mailx (providing /usr/bin/mailx). Selection Path Priority Status ------------------------------------------------------------ * 0 /usr/bin/heirloom-mailx 60 auto mode 1 /usr/bin/bsd-mailx 50 manual mode 2 /usr/bin/heirloom-mailx 60 manual mode 3 /usr/bin/mail.mailutils 30 manual mode Press enter to keep the current choice[*], or type selection number:

LC_ALL �� LANG ��ݒ肵�����̈Ⴂ

������ƋC�ɂȂ����̂Ń����B ���� Ubuntu14.04 �ł��B

�ݒ肷��O�B

$ locale

LANG=en_US.UTF-8

LANGUAGE=en_US:en

LC_CTYPE="en_US.UTF-8"

LC_NUMERIC="en_US.UTF-8"

LC_TIME="en_US.UTF-8"

LC_COLLATE="en_US.UTF-8"

LC_MONETARY="en_US.UTF-8"

LC_MESSAGES="en_US.UTF-8"

LC_PAPER="en_US.UTF-8"

LC_NAME="en_US.UTF-8"

LC_ADDRESS="en_US.UTF-8"

LC_TELEPHONE="en_US.UTF-8"

LC_MEASUREMENT="en_US.UTF-8"

LC_IDENTIFICATION="en_US.UTF-8"

LC_ALL=

LC_ALL �� C ��ݒ肵���ꍇ�B

$ env LC_ALL=C locale LANG=en_US.UTF-8 LANGUAGE=en_US:en LC_CTYPE="C" LC_NUMERIC="C" LC_TIME="C" LC_COLLATE="C" LC_MONETARY="C" LC_MESSAGES="C" LC_PAPER="C" LC_NAME="C" LC_ADDRESS="C" LC_TELEPHONE="C" LC_MEASUREMENT="C" LC_IDENTIFICATION="C" LC_ALL=C

LANG �� C ��ݒ肵���ꍇ�B

$ env LANG=C locale LANG=C LANGUAGE=en_US:en LC_CTYPE="C" LC_NUMERIC="C" LC_TIME="C" LC_COLLATE="C" LC_MONETARY="C" LC_MESSAGES="C" LC_PAPER="C" LC_NAME="C" LC_ADDRESS="C" LC_TELEPHONE="C" LC_MEASUREMENT="C" LC_IDENTIFICATION="C" LC_ALL=

LC_ALL �ɐݒ肵���ꍇ�� LANG �͕ς��܂���ł����B

�R�}���h�̌��ʂ�2�s�ڈڍs���\�[�g����

1�s�ڂɃw�b�_�[���o�͂����R�}���h�̌��ʂ� 2�s�ڈȍ~�݂̂��\�[�g���悤�Ǝv���ė͋Z�B

$ df -T | sed '1d' | sort

sed �� 1�s�ڂ��폜���Ă��܂��B

�ŁA�w�b�_�[�s��lj��B

$ (df -T | head -n 1) && (df -T | sed '1d' | sort)

Filesystem Type 1K-blocks Used Available Use% Mounted on

/dev/sda1 ext3 19091584 2018084 16097016 12% /

none tmpfs 102400 0 102400 0% /run/user

none tmpfs 16432604 0 16432604 0% /run/shm

none tmpfs 4 0 4 0% /sys/fs/cgroup

none tmpfs 5120 0 5120 0% /run/lock

tmpfs tmpfs 3286524 844 3285680 1% /run

udev devtmpfs 16421864 4 16421860 1% /dev

netstat ���[�e�B���O����\������

�m��Ȃ��I�v�V�����������̂ŁA�����B

$ netstat -r

Kernel IP routing table

Destination Gateway Genmask Flags MSS Window irtt Iface

localnet * 255.255.255.0 U 0 0 0 eth0

default 192.168.1.1 0.0.0.0 UG 0 0 0 eth0

2�̃R�}���h�̏o�͂�1�ɂ܂Ƃ߂�

�����������Ƃł͂Ȃ��̂ł����B

�R�}���h�̌��ʂɃw�b�_�[��t������������ł��� cat �łł��������H�ǂ����悤���ƍl���Č��ʗ͋Z�B

$ (echo "MByte Directory") && (du -sm /home /opt /tmp /var)

MByte Directory

1 /home

1 /opt

87 /tmp

2 /var

�R�}���h���J�b�R�ň͂�� && �łȂ�����ł��܂����B

Linux �ŃO���[�v�Ƀ��[�U��lj�����

Linux �Ń��[�U��lj�������@�͂�������܂��� usermod ���g���ꍇ�͒��ӂ��K�v�ł��B

$ usermod -aG "�O���[�v��" "���[�U��"

���̂Ƃ��A"-G" �������ƌ��݂̐ݒ肳��Ă���O���[�v�������Ă��܂��̂� "-aG" �̂悤�� "a" ��t���Y��Ȃ��悤�ɂ��܂��B

gpasswd �Ƃ����R�}���h���g�����@������܂��B

$ gpasswd -a "���[�U��" "�O���[�v��"

���̃R�}���h�́A�O���[�v�𑀍삷��R�}���h�Ȃ̂� �O���[�v�����Ō�ɗ��邱�Ƃɒ��ӂ��܂��B ���[�U���́A"-a" �I�v�V�����̈������ɂȂ�܂��B

�ǂݎ���p�ŊJ�� view �R�}���h

vi �ŊJ���������� �㏑�����Ă��܂��ƕ|���� �Ƃ����Ƃ��� �ǂݎ���p�� vi ���J�� view �Ƃ����R�}���h������܂��B

�J���Ƃ��� vi �Ɠ����ł��B

$ view test.txt

����Ȃ� ������ƈ��S�Ɏg���܂��ˁB

���Ȃ݂� �ǂݎ���p�ŊJ���܂��� :w! �̂悤�Ɋ��Q���t�����Ə㏑���ł��܂��B

touch �R�}���h�ő��ΓI�ȓ��t���w�肷��

�T�[�o�̃o�b�`�����Ȃ�����Ă���ƁA �u����̃^�C���X�^���v�̃t�@�C���v�� �~�����Ȃ�Ƃ�������܂��B

touch �R�}���h�œ��t���w�肵����A ���̃t�@�C�������� �^�C���X�^���v��ݒ肷�邱�Ƃ͂ł��܂��� �������g�������ΓI�Ȏw�肾�� �ȒP�ɐݒ肷�邱�Ƃ��ł��܂��B

$ touch -d "1 day ago" test.txt

ago ����Ȃ��ĕ��ł� OK �ł��B

$ touch -d "-1 hour" test.txt

�����w��ł��܂��B

$ touch -d "-2 day -1 hour" test.txt

���̗Ⴞ�ƍ��v���� 4 ���O�ɂȂ�܂��B

$ touch -d "-2 day -2 day" test.txt

���̕����̑��Ύw��́A date �R�}���h�ł��g�p�ł���̂� ���O�ɂǂ��Ȃ邩�m�F���邱�Ƃ��ł��܂��B

$ date -d "-2 day -2 hour"

seq �Ƃ����֗����ۂ��R�}���h

�ȉ��̋L����ǂ�ŁAseq �Ȃ�ăR�}���h������E�E�E�Ǝv�����̂Ń����B

[�Q�l]

seq�R�}���h���ƂĂ��֗��������� - �ԂĂ��̃��O�łԃ��O

�����Ă݂܂��傤�B

$ seq 3

1

2

3

�ǂ��ł��ˁB

�J�n�I�����w��ł���悤�ł��B

$ seq 2 5

2

3

4

5

���Z���ł���݂����ł��B

$ seq 10 -2 5

10

8

6

���ɂ��������낦����A��蕶����ς�����i�f�t�H���g�͉��s�j�A�������w�肵����ł���悤�ł��B

$ seq -s, 2 8 2,3,4,5,6,7,8 $ seq -w 9 12 09 10 11 12 $ seq -f "%03g" 2 4 002 003 004

����Ȏg�������B�i2�����Ƃ̓��t���j

$ for i in `seq 0 2 30`; do date +"%Y-%m-%d (%a)" -d "$i day"; done; 2015-08-26 (Wed) 2015-08-28 (Fri) 2015-08-30 (Sun) 2015-09-01 (Tue) 2015-09-03 (Thu) 2015-09-05 (Sat) 2015-09-07 (Mon) 2015-09-09 (Wed) 2015-09-11 (Fri) 2015-09-13 (Sun) 2015-09-15 (Tue) 2015-09-17 (Thu) 2015-09-19 (Sat) 2015-09-21 (Mon) 2015-09-23 (Wed) 2015-09-25 (Fri)

�ȒP�ɐ������鐔�����w��ł���̂� �m���ɕ֗��ł��ˁB

bash �őO�̃R�}���h�̈����������g�p����

�R�}���h�����s����Ƃ��� �R�}���h�̑O�� echo ��t���Ď����Ă݂邱�Ƃ�����܂��B

$ export testfile=dummy.txt $ echo rm $testfile rm dummy.txt

���̌�Aecho �������Ď��s����킯�ł��� !* ���g�����Ƃ� �������Ƃ��ȒP�Ɏ��s�ł��܂��B

$ export testfile=dummy.txt $ echo rm $testfile rm dummy.txt $ !* rm $testfile rm: cannot remove `dummy.txt': No such file or directory

!* �ɂ́A�O�Ɏ��s�����R�}���h�́u�R�}���h�����̃��[�h�v���i�[����邽�� echo �̌�납����s�����킯�ł��B

!^ ���Ɓu�R�}���h�����̃��[�h�v�̐擪�A !$ ���u�R�}���h�����̃��[�h�v�̍Ō�ɂȂ�܂��B

$ echo 1 2 3 4 5 1 2 3 4 5 $ echo !^ echo 1 1 $ echo 1 2 3 4 5 1 2 3 4 5 $ echo !$ echo 5 5

���Ȃ݂ɑO�Ɏ��s�����R�}���h�S�̂� !! �Ɋi�[����邽�� !! �������ƁA�O�̃R�}���h���Ď��s�ɂȂ�܂��B

$ echo 1 2 3 4 5 1 2 3 4 5 $ !! echo 1 2 3 4 5 1 2 3 4 5

���Ȃ݂ɁA���́u�R�}���h�����̃��[�h�v�̓p�C�v��_�C���N�g���܂݂܂��B

$ echo 1 2 3 4 5 > /tmp/test.txt $ echo !$ echo /tmp/test.txt /tmp/test.txt

�g���Ƃ��́A������Ƃ������ӂł��B

���_�C���N�g������ 0�o�C�g�㏑��

bash �ł́A���̂悤�Ƀ��_�C���N�g������ 0�o�C�g�̃t�@�C������邱�Ƃ��ł���悤�ł��B

����܂ł̓R�������_�C���N�g�Ƃ� /dev/null ���g���Ă܂����B

$ : > zero.txt $ cat /dev/null > zero.txt

���_�C���N�g�����ł����܂��B

$ > zero.txt $ ls -l zero.txt -rw-r--r-- 1 xxxxxx xxxxxx 0 2015-08-19 21:24 zero.txt

�V���v���ł����A�����ԈႢ�Ǝv��ꂻ���ł��ˁB

���ƒ��Ɏg�p����̂ɂ͕֗��ŗǂ������ł��B

SQLite �̃f�[�^�x�[�X�t�@�C���̃o�[�W�������m�F����

SQLite �ō쐬�����f�[�^�x�[�X�̃t�@�C���� SQLite �̂ǂ̃o�[�W�����ō쐬�������ł��� file �R�}���h�Ŋm�F���邱�Ƃ��ł��܂����B �iUbuntu10.04���j

$ file database.sqlite2 database.sqlite2: SQLite 2.x database $ file database.sqlite3 database.sqlite3: SQLite 3.x database

Linux �Ńe�L�X�g���烉���_���� 1�s�擾����

���Ђ����Ԃ�ł��B

cowsay �R�}���h�Ń����_���ɊG����ς������Ǝv���Ă�����ł����A ���̂��߂ɂ̓����_���ŊG�����w�肷��K�v������܂��B

�G���̈ꗗ�͎��̂悤�ȃR�}���h�Ŏ擾�ł��܂��B

$ cowsay -l | grep -v "^Cow"

��������A�����_���� 1�s�擾���܂��B �ŏ��� Bash �̔z����g���� ���̂悤�ɂ���Ă܂����B

$ LIST=(`cowsay -l | grep -v "^Cow"`) $ FMT=${LIST[$(($RANDOM % ${#LIST[@]}))]}

1�s�łł��Ȃ����ƒ��ׂĂ����� sort �R�}���h�ɂ� -R �I�v�V������ �������肷�邱�Ƃ�m��܂����B

���̂悤�ɂȂ�܂����B

$ cowsay -l | grep -v "^Cow" | sed -e "s/ /\n/g" | sort -R | head -n 1

cowsay �� fortune ������āA����Ŋ����ł��B

$ fortune | cowsay -n -f `cowsay -l | grep -v "^Cow" | sed -e "s/ /\n/g" | sort -R | head -n 1`

�E�E�E�Ǝv���Ă�����Ashuf �Ȃ�ăR�}���h������悤�� ���̂悤�ɂȂ�܂����B

$ fortune | cowsay -n -f `cowsay -l | grep -v "^Cow" | sed -e "s/ /\n/g" | shuf -n 1`

�F�X�Ƃ���܂��ˁB

�e�L�X�g�����͊o���Ă����ƁA�J�����̂�����Ƃ������ƂɎg���ĕ֗��Ȃ̂� �V�тȂ���o���Ă����������̂ł��B

watch �R�}���h

Linux �ɂ� watch �Ƃ����֗��ȃR�}���h������܂��B

�f�B���N�g���Ƀt�@�C���������������̂�҂��Ă�Ƃ��� �悭 ls �R�}���h��A�ł���̂ł��� watch �R�}���h���g���A��������ɂ���Ă���܂��B

$ watch ls -l /tmp

����ŁA�i�f�t�H���g�́j2�b�Ԋu�Ō��ʂ�\�����Ă���܂��B

�Ԋu��ύX����Ƃ��� "-n" �I�v�V�����ł��B

$ watch -n 5 ls -l /tmp

����� 5�b�Ԋu�ɂȂ�܂��B

"-d" �I�v�V�����ŁA�ύX�ӏ����n�C���C�g���邱�Ƃ��ł��܂��B

$ watch -d ls -l /tmp

�������A���̍X�V�^�C�~���O�Ńn�C���C�g�������Ă��܂��̂� �n�C���C�g���c�������ꍇ�� "-d" �I�v�V������ �X�� "=cumulative"��t���܂��B

$ watch -d=cumulative ls -l /tmp

bash �� cd - �� ���ϐ� OLDPWD

bash �ł� cd - �Ƃ��邱�Ƃ� 1�O�icd ����O�j�̃f�B���N�g���Ɉړ����邱�Ƃ��ł��܂��B

/var$ cd - /tmp /tmp$

���� 1�O�̃f�B���N�g���̃p�X�� ���ϐ� OLDPWD �Ɏ����Ă��܂��B

1�x�� cd ���g���Ă��Ȃ��ꍇ ���ϐ� OLDPWD �� ��Ȃ̂� cd - ���Ă� �f�B���N�g�����ړ��ł��܂���B

~$ bash ~$ cd - bash: cd: OLDPWD not set

�t�� ���ϐ� OLDPWD �� �l��ݒ肷��� cd - �� ���̃f�B���N�g���Ɉړ��ł��܂��B

~$ export OLDPWD=/tmp ~$ cd - /tmp /tmp$

find �R�}���h�� -exec �I�v�V������ + �� ; �ɂ���

find �� man �����Ă����� -exec �ɂ��� �ȉ��̂悤�ɏ����Ă���܂����B

-exec command ;

-exec command {} +

�v���X�H �Ǝv�����p���ǂ܂��ɑ������B �����Ă���y�[�W������܂����B

[�Q�l]

Linux - find �� -exec option�̖����ɂ� \; �� + �̈Ⴂ�B

- Qiita (2013/10/01)

$ find . -exec echo {} \; ./test1.txt ./test2.txt ./test3.txt

$ find . -exec echo {} + ./test1.txt ./test2.txt ./test3.txt

�Ȃ�قǁB

join �R�}���h�łł��邱�ƃC���C��

Linux �ɂ� join �Ƃ��� SQL�g���ɂ�����݈Ղ����ȃR�}���h������܂��B

���̃R�}���h�� 2�̃t�@�C���i�Е��͕W�����͉j�� �w�肵���t�B�[���h�Ō����������ʂ�Ԃ��Ă���܂��B

[text1.txt] 11111 aa1 22222 bb1 33333 cc1 55555 ee1

[text2.txt] 11111 aa2 33333 cc2 44444 dd2 66666 ff2

�t�B�[���h���w�肵�Ȃ��� 1�ڂ̃t�B�[���h�Ō������܂��B

$ join test1.txt test2.txt

11111 aa1 aa2

33333 cc1 cc2

INNER JOIN �ł��ˁB

test1.txt �� test2.txt �̗����ɑ��݂���

"11111" �� "33333" ���o�͂���܂����B

�O���������ł��܂��B

$ join -a1 test1.txt test2.txt 11111 aa1 aa2 22222 bb1 33333 cc1 cc2 55555 ee1

LEFT JOIN �ɂȂ�܂����B

test1.txt ����͑S�s���o�͂���Ă��܂��B

RIGHT JOIN ���ł��܂��B

$ join -a2 test1.txt test2.txt 11111 aa1 aa2 33333 cc1 cc2 44444 dd2 66666 ff2

test2.txt �̑S�s�ɂȂ�܂����B

"-a1" "-a2" �𗼕��w�肷�邱�Ƃ��ł��܂��B

$ join -a1 -a2 test1.txt test2.txt 11111 aa1 aa2 22222 bb1 33333 cc1 cc2 44444 dd2 55555 ee1 66666 ff2

����ŁA�ǂ��炩�̃t�@�C���� �t�B�[���h�����݂���s�� �o�͂���܂����B

cut �R�}���h�ȂǂŐ�o���� �����Ɏg�������ł��ˁB

$ join -a1 -a2 test1.txt test2.txt | cut -f1

11111

22222

33333

44444

55555

66666

�t�B�[���h���}�b�`���Ȃ��ꍇ�� �o�͂��邱�Ƃ��ł��܂��B

$ join -v1 test1.txt test2.txt 22222 bb1 55555 ee1

test1.txt �ɂ̂݃t�B�[���h�����݂���s�� �o�͂���܂����B

"-v1" �� "-v2" �� �ǂ�����w�肷��� �ǂ��炩�̃t�@�C���ɂ̂݃t�B�[���h�����݂���s���o�͂���܂��B

$ join -v1 -v2 test1.txt test2.txt 22222 bb1 44444 dd2 55555 ee1 66666 ff2

�w�肵���t�B�[���h�ł̔�r�Ȃ̂� diff �Ƃ͂�����ƈႢ�܂��ˁB

2�̃t�@�C���̍����Ȃ̂� �����̃`�F�b�N�Ɏg�������ł��B

$ join -v1 -v2 test1.txt test2.txt | cut -f1 22222 44444 55555 66666

�s�ԍ���t���� nl �R�}���h

Linux �ɂ͍s�ԍ���t���� nl �Ƃ����R�}���h������܂��B

�s�ԍ��t���邾���ł͂Ȃ��̂ł��� �[���@�艺�����g�����͂��܂���B

[test.txt] aaaaaaaaa bbbbbbbbb ccccccccc ddddddddd

$ nl test.txt

1 aaaaaaaaa

2 bbbbbbbbb

3 ccccccccc

4 ddddddddd

����Ȋ����ł��B

���ꂭ�炢�Ȃ� cat �ł��ł��܂��B

$ cat -n test.txt

1 aaaaaaaaa

2 bbbbbbbbb

3 ccccccccc

4 ddddddddd

nl �̓I�v�V�����Ȃ����Ƌ�s�͔ԍ���t���܂���B

$ nl test.txt

1 aaaaaaaaa

2 bbbbbbbbb

3 ddddddddd

4 eeeeeeeee

��s���ɂ��ԍ���t����ꍇ�̓I�v�V�������w�肵�܂��B

$ nl -b a test.txt 1 aaaaaaaaa 2 bbbbbbbbb 3 4 ddddddddd 5 eeeeeeeee

nl �Ȃ�ȒP�ɏ����l��ς��邱�Ƃ��ł��܂��B

$ nl -v 3 test.txt 3 aaaaaaaaa 4 bbbbbbbbb 5 ccccccccc 6 ddddddddd

1�s���Ƃ̑����l���w�肷�邱�Ƃ��ł��܂��B

$ nl -i 3 test.txt 1 aaaaaaaaa 4 bbbbbbbbb 7 ccccccccc 10 ddddddddd

awk �Ȃǂł��ł��Ȃ��͂Ȃ��ł��� �ȒP�Ȃ̂Ŋo���Ă����ƕ֗��ł��B

ls �R�}���h�̃^�C���X�^���v�̏���

ls �R�}���h�ŕ\�������^�C���X�^���v������ ���ϐ� LANG �ɂ���ĕς��܂��B

Ubuntu10.04 �� ls ���Ǝ��̂悤�ɂȂ�܂��B

LAMG=C

$ env LANG=C ls -lt -rw-r--r-- 1 root root 847 May 27 15:41 snmpd -rw-r--r-- 1 root root 258 Nov 28 2013 samba -rw-r--r-- 1 root root 876 Mar 17 2011 exim4 -rw-r--r-- 1 root root 64 Mar 17 2011 ntpdate

�^�C���X�^���v���Â��ꍇ�� �����ł͂Ȃ��A�N���\������܂��B

LANG=ja_JP.UTF-8

$ env LANG=ja_JP.UTF-8 ls -lt -rw-r--r-- 1 root root 847 May 27 15:41 snmpd -rw-r--r-- 1 root root 258 Nov 28 2013 samba -rw-r--r-- 1 root root 876 Mar 17 2011 exim4 -rw-r--r-- 1 root root 64 Mar 17 2011 ntpdate

LAMG=C �Ɠ����ł��ˁB

LANG=en_US.UTF-8

$ env LANG=en_US.UTF-8 ls -lt -rw-r--r-- 1 root root 847 2014-05-27 15:41 snmpd -rw-r--r-- 1 root root 258 2013-11-28 17:56 samba -rw-r--r-- 1 root root 876 2011-03-17 11:20 exim4 -rw-r--r-- 1 root root 64 2011-03-17 11:12 ntpdate

YYYY-MM-DD hh:mm �ɂȂ�܂��B

�w�肵�����Ƃ��� "--time-style" �I�v�V�������g���܂��B

$ ls -lt --time-style=+"%Y/%m/%d %H:%M:%S" -rw-r--r-- 1 root root 847 2014/05/27 15:41:05 snmpd -rw-r--r-- 1 root root 258 2013/11/28 17:56:50 samba -rw-r--r-- 1 root root 876 2011/03/17 11:20:45 exim4 -rw-r--r-- 1 root root 64 2011/03/17 11:12:01 ntpdate

����ōD���ȏ����ŕ\���ł��܂��B

find �R�}���h�ŕ����̃R�}���h�����s����

�����B

$ find /usr/local/lib/ -type d -exec dirname {} \; -exec basename {} \; /usr/local lib /usr/local/lib python2.6 /usr/local/lib/python2.6 site-packages /usr/local/lib/python2.6 dist-packages

-exec �I�v�V��������g���B

find �R�}���h�Ńf�B���N�g���̊K�w���[��������擾����

�����B

$ find /usr/local/lib/ -depth -type d /usr/local/lib/python2.6/site-packages /usr/local/lib/python2.6/dist-packages /usr/local/lib/python2.6 /usr/local/lib/

-depth �I�v�V������t����B

Raspberry Pi �� MRTG �����Ă݂� (3)

�O��̑��� SNMP �̐ݒ�ł��B �Ƃ肠���� SNMP ����f�[�^���擾�ł���悤�ɐݒ肵�Ă����܂��B

�܂� snmpd �̐ݒ�t�@�C����ҏW���܂��B

$ sudo vi /etc/snmp/snmpd.conf

���e�͎��̂悤�Ȋ����ł��i�S���j�B

############################################################################### # # AGENT BEHAVIOUR # # Listen for connections from the local system only agentaddress udp:161 ############################################################################### # # ACCESS CONTROL # # sec.name source community com2sec PI_LOCAL localhost RASPBERRY_PI com2sec PI_NETWOEK 192.168.3.0/24 RASPBERRY_PI # group.name sec.model sec.name group LOCAL_GROUP v1 PI_LOCAL group LOCAL_GROUP v2c PI_LOCAL group LOCAL_GROUP usm PI_LOCAL group NETWORK_GROUP v1 PI_NETWOEK group NETWORK_GROUP v2c PI_NETWOEK group NETWORK_GROUP usm PI_NETWOEK # view.name incl/excl subtree mask view all included .1 80 # group.name context sec.model sec.level match read write notif access LOCAL_GROUP "" any noauth exact all none none access NETWORK_GROUP "" any noauth exact all none none ############################################################################### # # SYSTEM INFORMATION # syslocation Raspberry Pi raspbian syscontact Studio ODIN <xxxxx@xxxxx.xx.xx> sysservices 72

�l�b�g���[�N�� 192.168.3.x ���g�p���Ă���̂ŁA���͈̔͂���̃A�N�Z�X�������Ă��܂��B community ���� "RASPBERRY_PI" �̓p�X���[�h�̈Ӗ����܂܂�Ă���̂ŁA �R�s�y����ꍇ�́A�K�X�ύX���Ă��������B

syslocation �� syscontact �́A�����̏��ł��̂œK���ɁB

�ݒ�t�@�C���̕ҏW���I������� �T�[�r�X���ċN�����܂��B

$ sudo service snmpd restart

���Ƃ͎����� snmpd �ɃA�N�Z�X���Ă݂܂��B

$ sudo snmpwalk -v 2c -c RASPBERRY_PI localhost 1.3.6.1.4.1.2021

"RASPBERRY_PI" �́A�ݒ�t�@�C������ community ���A "1.3.6.1.4.1.2021" ���擾������̎��ʎq�ł��B

���̃R�}���h�����s���āA�����_�[���ƋA���Ă����琬���ł��B

����͂����܂ŁB

Raspberry Pi �� MRTG �����Ă݂� (2)

�Z���ł����A�O���̑����B

�O��A MRTG �ŃO���t������f�[�^���擾���邽�߂� SNMP �̃p�b�P�[�W������܂����B

�C���X�g�[���������ŋN�����Ă���̂Ō��Ă݂܂��B

$ netstat -lun Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State udp 0 0 127.0.0.1:161 0.0.0.0:*

���̂悤�� UDP 127.0.0.1 �őҋ@���Ă��܂��B

�T�[�o�����Ŏg�p����ꍇ�͂���ł��ǂ��̂ł��� �ʂ̃T�[�o����� SNMP �ɃA�N�Z�X���邱�Ƃ� �l���Đݒ��ύX���܂��B

SNMP �̐ݒ�t�@�C����ҏW���܂��B

$ sudo vi /etc/snmp/snmpd.conf

������B

# Listen for connections from the local system only agentAddress udp:127.0.0.1:161

�������܂��B

# Listen for connections from the local system only agentAddress udp:161

���Ƃ̓T�[�r�X���ċN���B

$ sudo /etc/init.d/snmpd restart

����ŕʃT�[�o������A�N�Z�X�ł���悤�ɂȂ�܂����B

$ netstat -lun Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State udp 0 0 0.0.0.0:161 0.0.0.0:*

����͂����܂ŁB

Raspberry Pi �� MRTG �����Ă݂� (1)

������� MRTG �̕��K���Ă� Raspberry Pi �� MRTG �����Ă݂����Ǝv���܂��B

�Ƃ肠�����p�b�P�[�W���ŐV�̏�ԂɁB

$ sudo apt-get update

���Ȃ݂� 2014-01-07-wheezy-raspbian �������Ă��܂��B

$ sudo apt-get upgrade

Reading package lists... Done

Building dependency tree

Reading state information... Done

The following packages have been kept back:

wolfram-engine

The following packages will be upgraded:

curl dpkg dpkg-dev file libcurl3 libcurl3-gnutls libdpkg-perl libgnutls26 libmagic1 libxfont1 libyaml-0-2

lsb-base python3-pifacedigital-scratch-handler tzdata udisks wget

16 upgraded, 0 newly installed, 0 to remove and 1 not upgraded.

Need to get 8,296 kB of archives.

After this operation, 570 kB of additional disk space will be used.

Do you want to continue [Y/n]?

�C���X�g�[���O��̃p�b�P�[�W�̃��X�g���擾���Ă����܂��B

$ sudo dpkg -l > ~/package_list_before_mrtg.txt

MRTG �� SNMP �̃f�[�����ƃN���C�A���g�����܂��B

$ sudo apt-get install snmpd snmp mrtg

Reading package lists... Done

Building dependency tree

Reading state information... Done

The following extra packages will be installed:

libio-socket-inet6-perl libperl5.14 libsensors4 libsnmp-base libsnmp-session-perl libsnmp15

libsocket6-perl

Suggested packages:

lm-sensors snmp-mibs-downloader mrtg-contrib

The following NEW packages will be installed:

libio-socket-inet6-perl libperl5.14 libsensors4 libsnmp-base libsnmp-session-perl libsnmp15

libsocket6-perl mrtg snmp snmpd

0 upgraded, 10 newly installed, 0 to remove and 1 not upgraded.

Need to get 5,863 kB of archives.

After this operation, 9,507 kB of additional disk space will be used.

Do you want to continue [Y/n]?

�r���� "Make /etc/mrtg.cfg owned by and readable only by root?" �Ƃ��������̂� "Yes" �Ɠ����Ă����܂��B

$ sudo dpkg -l > ~/package_list_after_mrtg.txt

�C���X�g�[���O��̃p�b�P�[�W�̍����͎��̂悤�Ȋ����B

$ cd $ diff package_list_after_mrtg.txt package_list_before_mrtg.txt 292d291 < ii libio-socket-inet6-perl 2.69-2 all object interface for AF_INET6 domain sockets 357d355 < ii libperl5.14 5.14.2-21+rpi2 armhf shared Perl library 403d400 < ii libsensors4:armhf 1:3.3.2-2+deb7u1 armhf library to read temperature/voltage/fan sensors 413,416d409 < ii libsnmp-base 5.4.3~dfsg-2.7 all SNMP (Simple Network Management Protocol) MIBs and documentation < ii libsnmp-session-perl 1.13-1 all Perl support for accessing SNMP-aware devices < ii libsnmp15 5.4.3~dfsg-2.7 armhf SNMP (Simple Network Management Protocol) library < ii libsocket6-perl 0.23-1 armhf Perl extensions for IPv6 549d541 < ii mrtg 2.17.4-2 armhf multi router traffic grapher 639,640d630 < ii snmp 5.4.3~dfsg-2.7 armhf SNMP (Simple Network Management Protocol) applications < ii snmpd 5.4.3~dfsg-2.7 armhf SNMP (Simple Network Management Protocol) agents

�ȂF�X�Ɠ���܂����B

����͂����܂ŁB

Raspberry Pi �� rasbian �� 2014-01-07 �ɂ���

�v���Ԃ�� Raspberry PI �l�^�ł��B

����� raspbian ��z�z����Ă���ŐV�ɂ������Ǝv���܂��B �Ƃ����킯�ŁA 2014-01-07-wheezy-raspbian �����܂��B

[�Q�l�T�C�g]

Raspberry Pi ���� (26) �܂Ƃ� - Jun's homepage

�����̂悤�� ��L�T�C�g���Q�l�ɐi�߂܂��B

�_�E�����[�h���āA�𓀂��āASD�J�[�h�ɏ�������ŋN���B

2013-12-20-wheezy-raspbian �� Mathematica �������Ă܂��B �K���ɃR�}���h�����s�B

$ mathematica -v

10.0

�Ȃo�܂����B

2013-09-25-wheezy-raspbian ���� Java �������Ă܂��B

$ java -version

java version "1.7.0_40"

Java(TM) SE Runtime Environment (build 1.7.0_40-b43)

Java HotSpot(TM) Client VM (build 24.0-b56, mixed mode)

�Ƃ肠���������܂ŁB

���炭�����Ă����ƒǂ�������̂���ςł��ˁB

bash �ŗ������g��

bash �ɂ͗������擾�ł���ϐ��H�� �p�ӂ���Ă��܂��B

$ echo $RANDOM 2036

�J��Ԃ��ĂԂƈႤ�l���Ԃ�܂��B

$ echo $RANDOM 2036 $ echo $RANDOM 17653

man �ɂ͎��̂悤�ɂ���܂��B

RANDOM Each time this parameter is referenced, a random integer between 0 and 32767 is generated. The sequence of random numbers may be initialized by assigning a value to RANDOM. If RANDOM is unset, it loses its special properties, even if it is subsequently reset.

�͈͂� 0 �` 32767 �̂悤�ł��B

�͈͂��w�肵�����ꍇ�́A % �ŗ]������߂܂��B

$ echo $(($RANDOM % 10)) 7

printf �� 0�l�߂ɂ��ł��܂��B

$ VAL=`printf "%05d" $RANDOM` $ echo $VAL 02036

RANDOM �ɒl��ݒ肷��ƁA�����̎�����߂邱�Ƃ��ł��܂��B

$ RANDOM=3 $ echo $RANDOM 17653 $ echo $RANDOM 12499 $ RANDOM=3 $ echo $RANDOM 17653 $ echo $RANDOM 12499

��������w�肷��ƁA�����l���Ԃ��Ă��܂��B

find �� �����̃R�}���h�����s����

find �R�}���h�擾�����p�X�� -exec �I�v�V�������g���� �R�}���h�����s���邱�Ƃ��ł��܂��B

$ find . -mtime 3 -exec rm {} \;

-exec �������� �����̃R�}���h�����s���邱�Ƃ��ł��܂��B

$ find . -mtime 3 -exec echo {} \; -exec rm {} \;

type �R�}���h�̌��ʂ� "is hashed"

type �R�}���h�� ����\������� ���܂� "is hashed" �ƕ\������邱�Ƃ�����܂��B

$ type sl sl is hashed (/usr/games/sl)

�Ȃ낤�H�Ǝv���Ē��ׂĂ݂�� ���̃T�C�g�Ɂu�R�}���h�̏ꏊ�֍����ɃA�N�Z�X���邽�߂ɁA�悭�g�p����p�X���L���b�V���ɂƂ��Ă��āA�n�b�V���e�[�u�������̃L���b�V���v�� �����Ă���܂����B

[�Q�l]

type��which�̈Ⴂ���āH - OpenGroove

�Ȃ�قǁB

���݃n�b�V���e�[�u���ɃL���b�V������Ă���R�}���h�� hash �R�}���h�Ŋm�F�ł��܂��B

$ hash

hits command

1 /usr/bin/man

3 /usr/games/sl

hash �R�}���h�� �V�F���̑g�ݍ��݃R�}���h�ł��B

$ type hash

hash is a shell builtin

"-r" �I�v�V������ �n�b�V���e�[�u�����폜�ł��܂��B

$ hash -r

�폜��Ɋm�F���Ă݂܂��B

$ hash

hash: hash table empty

��ɂȂ��Ă��܂��B

�n�b�V���e�[�u������ɂȂ�����Ԃ� ���� 1 �x���Ă݂܂��B

$ type sl

sl is /usr/games/sl

"is hashed" ���\������Ȃ��Ȃ�܂����B

trap �R�}���h�́A�V�F���̑g�ݍ��݃R�}���h

���̑O�� �⑫�ɂȂ�̂ł����A trap �R�}���h�� �V�F���̑g�ݍ��݃R�}���h�ł��B

�Ƃ肠���� which �R�}���h�B

$ which trap

�����p�X�ɂȂ����� �����\������܂���B

type �R�}���h�� ����\�����邱�Ƃ��ł��܂��B

$ type trap trap is a shell builtin

�V�F���̑g�ݍ��݃R�}���h�̏ꍇ �p�X�ł͂Ȃ� "shell builtin" �ƕ\������܂��B

cd �� alias �R�}���h�Ȃǂ����l�ł��B

$ type cd cd is a shell builtin $ type alias alias is a shell builtin

�g�ݍ��݃R�}���h�łȂ��� "shell builtin" �ȊO���\������܂��B

$ type find find is /usr/bin/find $ type ls ls is aliased to `ls -F'

�������A�g�ݍ��݃R�}���h�ł�

�R�}���h�� alias ��ݒ肳��Ă���� "is aliased" ��

�\������܂��B

�i"-t" �I�v�V�����͌^�̂ݕ\���j

$ type -t cd builtin $ alias cd="cd" $ type -t cd alias $ unalias cd $ type -t cd builtin

���Ȃ݂� type �R�}���h���g�ݍ��݃R�}���h�ł��B

$ type type

type is a shell builtin

�V�F���X�N���v�g�̏I�����ɏ��������s��������

���b�N�t�@�C����ꎞ�t�@�C���̍폜�ȂǁA�V�F���X�N���v�g�̏I������ ���s�����������Ƃ����̂�����܂��B �ُ�I�����ɍ폜���Ă����Ȃ���Ȃ�Ȃ��ꍇ�Ȃ� ����L�q����̂͑�ςł��B

����ȂƂ��Ɏg���� trap �Ƃ����R�}���h������܂��B

trap �R�}���h�͎��̂悤�ɏ����ƃV�O�i�����w�肵�܂��B

trap "echo hogehoge" EXIT

�Ƃ肠�����R�}���h���C���Ŏ����Ă݂܂��B

INT �� [Ctrl]+[c] �Ȃǂɂ�銄�荞�݂̃V�O�i���ł��B

$ trap "echo hogehoge" INT

[Ctrl]+[c] �������� "echo hogehoge" �����s���܂��B

$ trap "echo hogehoge" INT $ ^Chogehoge $ ^Chogehoge

��������ɂ̓V�O�i���������w�肵�܂��B

$ trap INT $ ^C

[Ctrl]+[c] �������Ă�����������܂���B

�V�F���X�N���v�g�̒��� ���̂悤�ɏ����Ă����� �I�����Ƀt�@�C�����폜���Ă���܂��B

trap "rm text1.txt" EXIT

EXIT �̓v���Z�X�I�����̃V�O�i���Ȃ̂� �V�F���X�N���v�g�̏I�����g���b�v���Ă���܂��B

�����̐i�s��Ԃɂ���č폜����t�@�C����������Ƃ��� ���̂悤�ɍĒ�`������@�őΉ����邱�Ƃ��ł��܂��B

DELFILE="${DELFILE} test1.txt"

trap "rm ${DELFILE}" EXIT

(...����....)

DELFILE="${DELFILE} test2.txt"

trap "rm ${DELFILE}" EXIT

���݂̐ݒ���e�� "-p" �I�v�V�����A �V�O�i���̈ꗗ�� "-l" �I�v�V������ �\�������邱�Ƃ��ł��܂��B

find �R�}���h�̌��ʂŃt�@�C�����폜����Ƃ��̃���

���������ł��B

find �R�}���h�ň�莞�Ԍo�߂����t�@�C���� �폜����Ƃ��Ɏ��̂悤�ɏ������肵�܂��B

$ find /var/log/hoge -mtime +3 -exec rm {} \;

����� 3 ���ȏソ�����t�@�C���������Ă����E�E�E�Ǝv����ł��� ���ꂾ�ƃf�B���N�g�� /var/log/hoge ���܂܂�Ă��܂��܂��B

�e�X�g�� /var/log/hoge �����������i3���o�߂��Ă��Ȃ��ꍇ�j�� ���̃f�B���N�g����3���ȓ��Ƀt�@�C�����i�[�����ꍇ�́A ���o����Ȃ��̂ŋC�t���ɂ����̂ł����A ���炭�Ώۂ̃f�B���N�g���ɑ���X�V���Ȃ���Ԃ� ��̂悤�ȃR�}���h�����s����� �u�f�B���N�g���Ȃ̂ō폜�ł��Ȃ���v�G���[���o�܂��B

�ł��̂� "-type" �I�v�V�����̎w���Y��Ȃ��悤�ɂ��܂��B

$ find /var/log/hoge -type f -mtime +3 -exec rm {} \;

����Ńt�@�C���������ΏۂɂȂ�܂��B

�R�}���h�̃G�C���A�X���ɂ���

Redhat �ō�Ƃ��Ă��鎞�ɃA���H�Ǝv���� ���ׂ��̂Ń����Ƃ��ď����Ă����܂��B

Redhat �� root �ɂ� ���S�̂��߂� �G�C���A�X���g���� cp �R�}���h�̏㏑���m�F���f�t�H���g�ɂȂ��Ă��܂��B

# alias

alias cp='cp -i'

���̏�Ԃ��Ƌ����� "-f" �I�v�V������t���Ă� �m�F���Ă��܂��B ���̊m�F���~�߂��������Ƃ��� �G�C���A�X���폜����ȊO�ŕ��@�͂Ȃ��̂��Ǝv���� ���ׂĂ݂�Ƃ����Ƃ���܂����B

�G�C���A�X���ꎞ�I�ɖ����ɂ���ɂ� - @IT

�R�}���h�̑O�Ƀo�b�N�X���b�V����t����� �G�C���A�X���ɂł��邻���ł��B

�����Ă݂܂��B

$ alias cp='cp -i' $ alias alias cp='cp -i'

�܂��G�C���A�X��ݒ�B

�e�X�g�p�Ƀt�@�C�����쐬�B

$ touch test1.txt test2.txt

�����t�����Ɏ��s�B

$ cp test1.txt test2.txt

cp: overwrite `test2.txt'?

�m�F���Ă��܂��B

�o�b�N�X���b�V����t�����s�B

$ \cp -f test1.txt test2.txt

�m�F���Ă��܂���ł����B �G�C���A�X�������ɂȂ��Ă��܂��ˁB

�l�b�g���[�N�C���^�[�t�F�[�X���̌Œ艻

�ŋ߂� CentOS �� Fedora ������� �l�b�g���[�N�̃C���^�[�t�F�[�X���� eth0 �Ƃ��ł͂Ȃ� em1 �݂����Ȗ��O�ɂȂ��Ă��܂����Ƃ����邻���ł��B

em �Ƃ����̂� ethernet-on-motherboard �̗��̂悤�ł��B

����� biosdevname �Ƃ��� NIC �� �C���^�[�t�F�[�X�̑Ή����Œ艻���邽�߂� �d�g�݂������ŁA CentOS �ł́ANIC�i�� MAC �A�h���X�j���ς��� ethX �� X ���ς���Ă��܂����� ������Œ艻���邽�߂� 1�i�K���ۉ����Ă���悤�ł��B

[�Q�l�T�C�g]

ALL about Linux: CentOS 6.0 �� NIC �� ethX �̑Ή����Œ艻����

��L�T�C�g�ɂ��� DELL �̃}�V���� biosdevname �� ON �ɂȂ��Ă��邽�� ethX �ł͂Ȃ� emX �ƂȂ����悤�ł��B

RHEL �����l�ŁA�@�\�̗L���E�������ɂ��ď����Ă���܂����B

[�Q�l�T�C�g]

A.3. ���̋@�\�̗L�����Ɩ����� - Red Hat Customer Portal

Raspberry Pi �� tripwire �����Ă݂�

11/10 ���ŊJ�Â��ꂽ�wLPIC ���x��3 303 Security �Z�p��������Z�~�i�[�x�� tripwire ���������Ă����̂ŁA ���������Ȃ̂� Raspberry Pi �ɓ���Ă݂܂��B

tripwire �́A�t�@�C����₂Ȃǂ����o���邽�߂̃c�[���ł��B

���鎞�_�̃t�@�C���̏�Ԃ��f�[�^�x�[�X�ɕۑ����Ă����� �����_�̏�ԂƔ�r���邱�Ƃ��ł��܂��B

tripwire �̐ݒ�t�@�C����f�[�^�x�[�X���̂�������Ȃ��悤�� �F�ؗp�̃L�[���쐬����K�v������̂ł��� �ŋ߂́A�C���X�g�[���̗���ō쐬���邱�Ƃ��ł��܂��B

apt-get ���܂��B

$ sudo apt-get update $ sudo apt-get install tripwire

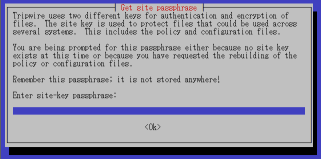

�r���A�T�C�g�L�[���쐬���邽�߂̃p�X�t���[�Y�����߂��܂��B

�T�C�g�L�[�́A�ݒ�t�@�C����������Ȃ����߂̃L�[�ł��B

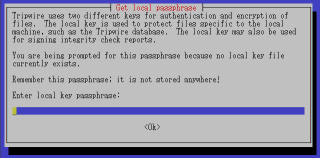

���[�J���L�[���쐬���邽�߂̃p�X�t���[�Y�����߂��܂��B

���[�J���L�[�́A�f�[�^�x�[�X��������Ȃ����߂Ɏg�p����L�[�ł��B

�C���X�g�[�����I��������A�f�[�^�x�[�X�����������܂��B ����ɂ���āA�u���̎��_�v�̃t�@�C���̏����f�[�^�x�[�X�ɕۑ����܂��B

$ sudo tripwire --init

Please enter your local passphrase:

���[�J���L�[�̃p�X�t���[�Y�����߂��܂��B

�f�[�^�x�[�X�ɕۑ��������ƁA�u�����_�v�̃t�@�C���̏��� ��r����ɂ� "--check" �I�v�V�������g�p���܂��B

$ sudo tripwire --check

���|�[�g���\������܂��B

���|�[�g���ēx�\������ɂ́A��r���ɐ������ꂽ twr �t�@�C����ǂݍ��݂܂��B

$ cd /var/lib/tripwire/report $ sudo twprint --print-report --twrfile raspberrypi-20121115-211440.twr

�u��r�������_�v�̃t�@�C���̏��Ńf�[�^�x�[�X���X�V����ɂ́A ��r���ɐ������ꂽ twr �t�@�C�����g���Ĉȉ��̂悤�ɃR�}���h�����s���܂��B

$ cd /var/lib/tripwire/report $ sudo tripwire --update -a --twrfile raspberrypi-20121115-211440.twr Please enter your local passphrase:

�f�[�^�x�[�X�̍X�V�Ȃ̂ł�͂胍�[�J���L�[�̃p�X�t���[�Y�����߂��܂��B

Linux �Ń��[�U���̕ύX

���[�U����ύX���郁���ł��B

�Ƃ����Ă��܂��O���[�v���B groupmod �R�}���h�� "-n" �I�v�V�����ŐV�������O���w�肵�܂��B

# groupmod -n NEW_NAME OLD_NAME

���[�U���� usermod �R�}���h�� "-l" �I�v�V�������g���܂��B

# usermod -l NEW_NAME OLD_NAME

�z�[���f�B���N�g�����ς���ꍇ�� ���̃z�[���f�B���N�g�������l�[�����Ă����� "-d" �I�v�V�����Ŏw�肵�܂��B

# mv /home/OLD_NAME /home/NEW_NAME # usermod -l NEW_NAME -d /home/NEW_NAME OLD_NAME

�Ώۂ̃��[�U�����O�C�����̏ꍇ�͕ύX�ł��܂���B

Bash �Ńp�C�v���Ă���Ƃ��̏I���X�e�[�^�X

Bash �Ńp�C�v���g���ăR�}���h�����s����� �I���X�e�[�^�X�́A�Ō�̃R�}���h�̌��ʂɂȂ�܂��B

���Ƃ��Ύ��̂悤�ȏꍇ

$ true | false | true

�Ԃ� false (�I���X�e�[�^�X 1�j������̂ł��� $? �Ŋm�F����� 0 �ɂȂ��Ă��܂��B

$ true | false | true $ echo $? 0

����� �Ō�� true �̏I���X�e�[�^�X�� 0 �̂��߂Ȃ̂ł��� ����ł͓r���ɃG���[�����������ǂ����킩��܂���B

�E�E�E�ƁA���炭�v���Ă����̂ł����A�ȉ��̃T�C�g�ɕ��@�������Ă���܂����B

[�Q�l]

�I���X�e�[�^�X - UNIX & Linux �R�}���h�E�V�F���X�N���v�g ���t�@�����X

Bash �̓���ϐ� $PIPESTATUS �ɓ��邻���ł��B

$ true | false | true $ echo ${PIPESTATUS[@]} 0 1 0 $ exit 3 | exit 12 | exit 0 $ echo ${PIPESTATUS[@]} 3 12 0

�z��̌`�œ���̂ŁA������g���p�C�v���̃R�}���h�̏I���X�e�[�^�X�� �m�F���邱�Ƃ��ł��܂��ˁB

Ubuntu10.04 �� /tmp �̑|��

Ubuntu10.04 �ɂ� tmpwatch �͓����ĂȂ����A�ł��ċN������� /tmp �͋�ɂȂ�̂� �����|�����Ă���̂��H�Ǝv���Ă�����ł��� ���̃T�C�g������� /etc/init/mounted-tmp.conf �ɐݒ肪����悤�ł��B

[�Q�l]

���܂ʂ���������(2010-07-21)

/etc/default/rcS �� TMPTIME �Ƃ����p�����[�^�� �폜�����܂ł̗P�\���Ԃ�ݒ�ł��邻���ł��B

wget �Ńv���L�V���o�R���Ȃ�

�Г��� wget ���g���Ă�Ƃ��͊O���ɐڑ����邽�߂� �v���L�V�̐ݒ�����Ă���̂ł����A �Г��̃T�[�o�ɐڑ�����Ƃ��Ȃ� �v���L�V���o�R���Ăق����Ȃ����Ă��Ƃ�����܂��B

$ wget --no-proxy http://.....

����Ȋ����Ńv���L�V���g�p���Ȃ��I�v�V���������܂��B

while ���[�v���̕ʃv���Z�X

while ���D���Ȃ̂Ŏ��̂悤�ȃ��[�v�� �悭�����܂��B

ls -1 | while read FILE

do

echo $FILE

done

����̓p�C�v���g���Ă���̂� while �ȍ~���ʃv���Z�X�ɂȂ��Ă��܂��܂��B �i���̐ԕ����̕������ʃv���Z�X�ł��j

ls -1 | while read FILE

do

echo $FILE

done

�Ȃ̂ŁA ���[�v���ŕϐ��̒l��ݒ肵�Ă� ���[�v�̊O�ł͎Q�Ƃ��邱�Ƃ��ł��܂���B

�Ⴆ�Ύ��̂悤�ȏꍇ

AAA=0 ls -1 | while read FILE do echo $FILE AAA=1 done echo $AAA

���ʂƂ��� 0 ���o�͂���܂��B

Linux �̃f�B�X�g���r���[�V�������ׂ�

�����Ă� Linux �̃f�B�X�g���r���[�V�������킩��Ȃ��ꍇ Ubuntu ���Ǝ��̂悤�� /etc/lsb-release ������킩���ł��� CentOS �́H�ƕ����ꂽ�̂Ń����B

$ cat /etc/lsb-release

[�Q�l]

�C���X�g�[������ Linux �f�B�X�g���r���[�V�������ƃo�[�W�������m�F����ɂ� - PRiMENON:DiARY

��̎Q�l�T�C�g�ɂ��� �Ƃ肠���� /etc/issue �A ���Ƃ� /etc �̉��� xxxx-release �݂����ȃt�@�C��������悤�ł��B

�Ȃ̂Ŏ��̂悤�ɂ��Ă����悢���ƁB

$ cat /etc/issue /etc/*-release

sshd �� IPv6 ���g�p���Ȃ�

Ubuntu10.04 �ł̐ݒ胁���ł��B

�i���̊����ꏏ���Ǝv���܂����E�E�E�j

�f�t�H���g�ł� IPv6 ���g�p����ݒ�ɂȂ��Ă���̂� netstat ����Ǝ��̂悤�ɂȂ�܂��B

$ netstat -ant | grep 22

tcp�@�@�@�@0�@�@�@0 0.0.0.0:22�@�@0.0.0.0:*�@�@�@ LISTEN

tcp6�@�@�@ 0�@�@�@0 :::22�@�@�@�@ :::*�@�@�@�@�@�@LISTEN

sshd �̐ݒ�t�@�C����ҏW���܂��B

$ sudo vi /etc/ssh/sshd_config

���̐ݒ��lj����܂��B

AddressFamily inet

sshd ���ċN�����܂��B

$ sudo service ssh restart

����� IPv6 �� LISTEN ���Ȃ��Ȃ�܂��B

$ netstat -ant | grep 22

tcp�@�@�@�@0�@�@�@0 0.0.0.0:22�@�@0.0.0.0:*�@�@�@ LISTEN

Ubuntu10.04 �ł� wget �̃v���L�V�ݒ�

Ubuntu10.04 �� wget �R�}���h���v���L�V�o�R�� �g�p����Ƃ��̃����ł��B

���ϐ��Őݒ肵�Ă���Ă��g���܂���ł����B

�ݒ�t�@�C����ύX���܂��B

$ sudo vi /etc/wgetrc

���̐Ԏ��̂悤�ɒlj����܂��B

# You can set the default proxies for Wget to use for http, https, # They will override the value in the environment. #https_proxy = http://proxy.yoyodyne.com:18023/ #http_proxy = http://proxy.yoyodyne.com:18023/ #ftp_proxy = http://proxy.yoyodyne.com:18023/ http_proxy = http://192.168.1.200:3128/ # If you do not want to use proxy at all, set this to off. #use_proxy = on use_proxy = on

�����OK�ł��B

�v���L�V�Ƀ��[�U�F���K�v�ȏꍇ�� ���̂悤�ɃR�}���h�ł��n�����Ƃ��ł��܂��B

$ wget --proxy-user=USERNAME \ --proxy-password=PASSWORD \ http://www.odin.hyork.net/

Ubuntu10.04 �� Webmin ������

Ubuntu10.04 �� Webmin �����郁���ł��B

Webmin �� obsolete �Ȃ̂� �f�t�H���g�ł� apt-get �œ���邱�Ƃ��ł��܂���B ����� deb �t�@�C���������Ă��ē���܂��B

�܂� deb �t�@�C���̎擾�B

$ wget http://prdownloads.sourceforge.net/webadmin/webmin_1.570_all.deb

Webmin �̃T�C�g�ɏ�����Ă��� URL ���� Not Found �ɂȂ�̂Œ��ӂ��Ă��������B

[�Q�l]

Webmin http://www.webmin.com/deb.html

�ˑ��W�̂���t�@�C�������܂��B Ubuntu10.04 �ł͎��̂悤�Ȋ����ł����B

$ sudo apt-get install apt-show-versions $ sudo apt-get install libapt-pkg-perl $ sudo apt-get install libnet-ssleay-perl $ sudo apt-get install libauthen-pam-perl $ sudo apt-get install libio-pty-perl

�Ō�ɗ��Ƃ��Ă��� deb �t�@�C�������܂��B

$ sudo dpkg --install webmin_1.570_all.deb

����ŏI���ł��B 10000 �|�[�g�� Webmin ���N�����܂��B

�p�X���[�h�����b�N����

Linux �ł� passwd �R�}���h���g���� ���[�U�̃p�X���[�h�����b�N���邱�Ƃ��ł��܂��B

�����p���[�U�̏����B

$ sudo useradd -M -d /tmp -s /bin/bash test01 $ echo "test01:hogehoge" | sudo chpasswd

���R�A����������[�U test01 �ɐ�ւ��邱�Ƃ��ł��܂��B

$ su - test01 �p�X���[�h: $ id uid=1002(test01) gid=1002(test01) �����O���[�v=1002(test01)

passwd �R�}���h�� "-l" �I�v�V������t���Ď��s���܂��B

$ sudo passwd -l test01 passwd: password expiry information changed.

����� test01 �ɐ�ւ��邱�Ƃ��ł��Ȃ��Ȃ�܂��B

$ su - test01 �p�X���[�h: su: �F�؎��s

���O�C�����ł��܂���B

������ root ����� ��ւ��邱�Ƃ��ł��܂��B

$ sudo su - test01 $ id uid=1002(test01) gid=1002(test01) �����O���[�v=1002(test01)

��������ɂ� "-u" �I�v�V�������g���܂��B

$ sudo passwd -u test01 passwd: password expiry information changed.

usermod �R�}���h���g���Ă��������Ƃ��ł��܂��B

$ sudo usermod -L test01

"-L" �����b�N�� "-U" �������ł��B�啶���Ȃ̂Œ��ӂł��B

$ sudo usermod -U test01

�������Ƃ����Ă���̂� passwd �R�}���h�Ń��b�N���� usermod �R�}���h�ʼn������邱�Ƃ��ł��܂��B

���[�U�̏�������O���[�v��\������

���[�U�̃O���[�v��\������ groups �Ƃ����R�}���h������܂��B

$ groups

ubuntu adm dialout cdrom plugdev lpadmin sambashare admin

���[�U���w�肵�Ȃ��� ���݂̃��[�U�̃O���[�v��\�����܂��B

���[�U���w�肷��ƃR�����ŋ���ĕ\�����Ă���܂��B

$ groups root

root : root

���[�U���w�肷�邱�Ƃ��ł��܂��B

$ groups root ubuntu

root : root

ubuntu : ubuntu adm dialout cdrom plugdev lpadmin sambashare admin

�Ȃ̂ŁA����Ȃ��Ƃ��ł��܂��B

$ groups `cut -f 1 -d : /etc/passwd` root : root daemon : daemon bin : bin sys : sys sync : nogroup games : games man : man lp : lp mail : mail news : news uucp : uucp proxy : proxy www-data : www-data backup : backup list : list irc : irc gnats : gnats nobody : nogroup libuuid : libuuid syslog : syslog sshd : nogroup landscape : landscape ubuntu : ubuntu adm dialout cdrom plugdev lpadmin sambashare admin postgres : postgres ssl-cert

�A�N�Z�X�����w�肵�ăf�B���N�g�����쐬����

mkdir �R�}���h�� �f�B���N�g�����쐬����Ƃ��� �A�N�Z�X�����ɐݒ肷�邱�Ƃ��ł��܂��B

"-m" �I�v�V�������w�肵�܂��B

$ mkdir -m 700 a

���Ă݂܂��B

$ ls -lF ���v 4 drwx------ 2 ubuntu ubuntu 4096 2011-11-20 23:54 a/

���R chmod ���g���Ă��ł��܂��� �o�b�`�����Ŏ��s������Ƃ��Ȃ� �R�}���h�̐��۔��肪 1 ��ōςނ̂ŕ֗��ȂƂ�������܂��B

find �Ŋm�F���Ȃ���R�}���h���s����

find �R�}���h�� "-exec" �ŃR�}���h�����s���邱�Ƃ��ł��܂��B

$ find . -type f -exec echo {} \; ./bbb.txt ./ccc.txt ./aaa.txt

rm �R�}���h�Ȃǂ� ���s���m�F����I�v�V���� "-i" ������̂� ������w�肷��ƃt�@�C�����ƂɊm�F���Ă���܂��B

$ find . -type f -exec rm -i {} \; rm: �ʏ�̋�t�@�C�� `./bbb.txt'���폜���܂���? rm: �ʏ�̋�t�@�C�� `./ccc.txt'���폜���܂���? rm: �ʏ�̋�t�@�C�� `./aaa.txt'���폜���܂���?

�R�}���h���̂Ɋm�F�̃I�v�V�������Ȃ��ꍇ find �R�}���h�� "-exec" �̑���� "-ok" ���g�p���܂��B

$ find . -type f -ok rm {} \; < rm ... ./bbb.txt > ? < rm ... ./ccc.txt > ? < rm ... ./aaa.txt > ?

����Ȋ����ɂȂ�܂��B

�ł����R�}���h�Ɏ��M���Ȃ��Ƃ��� �ڂŃ`�F�b�N���Ȃ��痬�������Ƃ��ɕ֗��ł��B

�A��������s�� 1 �s�ɂ܂Ƃ߂�

����ȃe�L�X�g������܂��B

aaaaaaaaaaa bbbbbbbbb ccccc dddddddd eeeeeeee fffff gggggg

�u��s�͍�肽�����ǁA���Ȃ̂ŏ����킯�ɂ������Ȃ��v ����ȂƂ��̘b�ł��B

���ʂ� cat ����Ǝ��̂悤�ɂȂ�܂��B

$ cat test.txt

aaaaaaaaaaa

bbbbbbbbb

ccccc

dddddddd

eeeeeeee

fffff

gggggg

�E�E�E���R�ł��ˁB

cat �̃I�v�V���� "-s" ���w�肵�܂��B

$ cat -s test.txt aaaaaaaaaaa bbbbbbbbb ccccc dddddddd eeeeeeee fffff gggggg

����ŁA�A��������s�� 1 �s�ɂȂ�܂����B

�t�@�C�����g���q�ŕ��ׂ�

�u�E�B���h�E�Y�ł�������ǂ����́H�v�Ƃ�����ł��B

�����B

$ touch aaa.txt $ touch bbb.sh $ touch ccc.log $ touch ddd.txt $ touch eee.cgi $ ls -l -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 aaa.txt -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 bbb.sh -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ccc.log -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ddd.txt -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:14 eee.cgi

ls �Ŋg���q�ŕ��ׂ�ɂ� "-X" �I�v�V�������g���܂��B

$ ls -lX -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:14 eee.cgi -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ccc.log -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 bbb.sh -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 aaa.txt -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ddd.txt

�g���q�ŕ��т܂����B

�f�B���N�g�����������Ă���ꍇ�͒��ӂ��K�v�ł��B

$ mkdir eee.d $ mkdir ggg $ ls -l -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 aaa.txt -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 bbb.sh -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ccc.log -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ddd.txt -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:14 eee.cgi drwxr-xr-x 2 ubuntu ubuntu 4096 2011-11-18 21:15 fff.d drwxr-xr-x 2 ubuntu ubuntu 4096 2011-11-18 21:15 ggg

"-X" �I�v�V�����̖��� ls �ł̓f�B���N�g�������O���ɕ��т܂��B

"-X" �I�v�V������t���܂��B

$ ls -lX drwxr-xr-x 2 ubuntu ubuntu 4096 2011-11-18 21:15 ggg -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:14 eee.cgi drwxr-xr-x 2 ubuntu ubuntu 4096 2011-11-18 21:15 fff.d -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ccc.log -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 bbb.sh -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:10 aaa.txt -rw-r--r-- 1 ubuntu ubuntu 0 2011-11-18 21:11 ddd.txt

�f�B���N�g������ "." ���܂܂�Ă���ꍇ�A�t�@�C���Ɠ����悤�� "." �������g���q�Ƃ��ĕ��ׂĂ��܂��܂��B

�t�@�C�����V�����Ƃ������R�s�[��ړ�����

�ȑO�u�R�s�[��ړ�����Ƃ��ɓ����̃t�@�C����ޔ������v�Ƃ����l�^�������܂����� cp �R�}���h�� mv �R�}���h�ɂ́A���ɂ��֗��ȋ@�\�i�������Ƃ𑼂̕��@�ł�낤�Ƃ���Ə�����Ԃ�������j������܂��B

�I�v�V���� "-u" �ł��B

���̃I�v�V�����́A�R�s�[��ړ�����t�@�C���̃^�C���X�^���v���㏑������t�@�C�������V�����ꍇ�̂݁A���������s���܂��B

�����B

$ ls -l -rw-r--r-- 1 ubuntu ubuntu 2 11/16 23:40 test1.cgi -rw-r--r-- 1 ubuntu ubuntu 4 11/16 23:42 test2.cgi ���V����

�I�v�V���� "-u" ��t���ăR�s�[���܂��B

$ cp -u test1.cgi test2.cgi $ ls -l -rw-r--r-- 1 ubuntu ubuntu 2 11/16 23:40 test1.cgi -rw-r--r-- 1 ubuntu ubuntu 4 11/16 23:42 test2.cgi ���㏑������Ȃ�

�R�s�[��� test2.cgi �̕����V�����̂ŏ㏑������܂���B

�ړ����Ă݂܂��B

$ mv -u test1.cgi test2.cgi $ ls -l -rw-r--r-- 1 ubuntu ubuntu 2 11/16 23:40 test1.cgi �������Ȃ� -rw-r--r-- 1 ubuntu ubuntu 4 11/16 23:42 test2.cgi ���㏑������Ȃ�

�㏑������Ȃ������łȂ��A���t�@�C�� test1.cgi ���c��܂��B

������ȑO�̃t�@�C���ޔ��̃I�v�V���� "-b" �ƍ��킹��� �w�^�C���X�^���v���V�����ꍇ�̂݁A�R�s�[�i�ړ��j���āA����ɑޔ��t�@�C�����쐬����x�Ƃ��������ɂȂ�܂��B

���ꂾ���ł��ʔ����ł��� ������o�b�`�����ɑg�ݍ��ނƁA �^�C���X�^���v�Ƃ����ʎ��̃t���O�� �㏑������^���Ȃ��𐧌�ł���悤�ɂȂ�܂��B

locate �R�}���h�ō����Ɍ�������

locate �R�}���h�́A�R�}���h�̎��s���Ƀt�@�C������������̂ł͂Ȃ� ���O�ɍ쐬�����f�[�^�x�[�X���g���Č�������̂ŁAfind �R�}���h���������Ō������邱�Ƃ��ł��܂��B

$ locate cgi (�ȗ�) /usr/share/doc/popularity-contest/examples/popcon-submit.cgi /usr/share/doc/python-pexpect/examples/cgishell.cgi.gz /var/lib/nginx/fastcgi /var/lib/nginx/scgi

�p�^�[���}�b�`���O���F�X�ł��܂��B

$ locate "*.cgi" /usr/lib/w3m/cgi-bin/dirlist.cgi /usr/lib/w3m/cgi-bin/multipart.cgi /usr/lib/w3m/cgi-bin/w3mhelp.cgi /usr/lib/w3m/cgi-bin/w3mmail.cgi /usr/lib/w3m/cgi-bin/w3mman2html.cgi /usr/share/doc/popularity-contest/examples/popcon-submit.cgi

�����Ƀf�[�^�x�[�X���g���̂ŁA���������̃t�@�C�����������邱�Ƃ͂ł��܂���B

$ touch /var/www/test.cgi $ locate test.cgi

�f�[�^�x�[�X���X�V����ɂ� updatedb �R�}���h���g���܂��B

$ sudo updatedb

����ŏo�Ă��܂��B

$ locate test.cgi

/var/www/test.cgi

�f�[�^�x�[�X�̍X�V�� �������� cron �Ŗ��������悤�ɂȂ��Ă��܂��B Ubuntu �̏ꍇ�� /etc/cron.daily �ɂ���܂��B

$ ls -l /etc/cron.daily/mlocate

-rwxr-xr-x 1 root root 606 2010-03-24 19:16 /etc/cron.daily/mlocate

���ӂ��Ȃ��Ă͂����Ȃ��̂� /tmp �� /var/spool �Ȃǂ͏��O�̐ݒ肪����Ă��肵�� �������Ă��o�Ă��Ȃ��ꍇ������܂��B

Ubuntu �̏ꍇ /etc/updatedb.conf �ɐݒ肳��Ă��܂��B

$ cat /etc/updatedb.conf

PRUNE_BIND_MOUNTS="yes"

# PRUNENAMES=".git .bzr .hg .svn"

PRUNEPATHS="/tmp /var/spool /media"

PRUNEFS="NFS nfs nfs4 rpc_pipefs afs binfmt_misc proc smbfs autofs iso9660 ncpfs coda devpts ftpfs devfs mfs shfs sysfs cifs lustre_lite tmpfs usbfs udf fuse.glusterfs fuse.sshfs ecryptfs fusesmb devtmpfs"

�V���{���b�N�����N�̏��L�҂�ύX����

�V���{���b�N�����N�� chown �� �I�v�V�����Ȃ��Ŏ��s����� �����N��̏��L�҂��ς���Ă��܂��܂��B

�܂��������܂��B

$ mkdir directory $ ln -s directory link $ ls -l ���v 4 drwxr-xr-x 2 ubuntu ubuntu 4096 directory lrwxrwxrwx 1 ubuntu ubuntu 9 link -> directory

����Ȋ����B

�I�v�V�����Ȃ��� �V���{���b�N�����N�� chown ���܂��B

$ sudo chown root link $ ls -l ���v 4 drwxr-xr-x 2 root ubuntu 4096 directory lrwxrwxrwx 1 ubuntu ubuntu 9 link -> directory

�����N�� (directory) �̏��L�҂��ς��܂����B

"-h" �I�v�V������t���܂��B

$ sudo chown -h root link $ ls -l ���v 4 drwxr-xr-x 2 ubuntu ubuntu 4096 directory lrwxrwxrwx 1 root ubuntu 9 link -> directory

����ŃV���{���b�N�����N�̏��L�҂��ς��܂����B

�R�s�[��ړ�����Ƃ��ɓ����̃t�@�C����ޔ�����

Linux �� cp �R�}���h�ŃR�s�[�������� mv �R�}���h�ňړ�����Ƃ��ɁA �R�s�[���ړ���ɓ����̃t�@�C��������� �ʏ�͏㏑�����Ă��܂��܂��B

���� 2 �̃R�}���h�ɂ� �����̃t�@�C�����������Ƃ��� ���̃t�@�C����ޔ�������I�v�V����������܂��B

���̂悤�� a/ �� b/ �̂ǂ���ɂ� c.txt ������Ƃ��܂��B

$ ls a/ c.txt $ ls b/ c.txt

�ʏ�� cp �R�}���h���Ə㏑�����邾���ł��B

$ cp a/c.txt b/ $ ls b/ c.txt ���㏑�����ꂽ�t�@�C��

-b �I�v�V������t���܂��B

$ cp -b a/c.txt b/ $ ls b/ c.txt c.txt~

���̂悤�� c.txt~ ���ł��܂��B

������Ƃ킩��ɂ����ł��� c.txt ���㏑�����ꂽ�t�@�C����

���X������ c.txt �� c.txt~ �ɂȂ��Ă��܂��B

���Ȃ݂� Linux �ł� �t�@�C�����̍Ō�� ~ ���t���Ă���ꍇ �ޔ������t�@�C����ꎞ�t�@�C���ł���ꍇ�������ł��B

�ۑ������̂� 1 ���ゾ���Ȃ̂� ������x�R�s�[������� ���� c.txt �� c.txt~ �ɂȂ�܂��B

�o�b�`�����Ȃ� 1 ���ゾ���c���Ă����Ηǂ��Ƃ��Ȃ� ���̕��@�ł����������Ǝ�y�ł��B

LPIC Level3 Specialty 304 ���Ă��܂���

��T�A�O����悤�Ǝv���Ă� LPIC Level3 Specialty 304 ���Ă��܂����B

�M���M���ł������A�����̂悤�ɊȒP���̌��L�������܂����B

�V�F���̑g�ݍ��݃R�}���h�̈ꗗ��\������

bash �̑g�ݍ��݃R�}���h�̈ꗗ��\������ɂ� �g�ݍ��݃R�}���h�� help ���g���܂��B

$ help GNU bash, version 4.1.5(1)-release (i486-pc-linux-gnu) These shell commands are defined internally. Type `help' to see this list. Type `help name' to find out more about the function `name'. Use `info bash' to find out more about the shell in general. Use `man -k' or `info' to find out more about commands not in this list. A star (*) next to a name means that the command is disabled. job_spec [&] history [-c] [-d offset] [n] or hist> (( expression )) if COMMANDS; then COMMANDS; [ elif C> . filename [arguments] jobs [-lnprs] [jobspec ...] or jobs > : kill [-s sigspec | -n signum | -sigs> [ arg... ] let arg [arg ...] [[ expression ]] local [option] name[=value] ...

�g�ݍ��݃R�}���h�̏ڍׂ�����ɂ� help �̌�ɃR�}���h�𑱂��ď����܂��B

$ help bg bg: bg [job_spec ...] Move jobs to the background. Place the jobs identified by each JOB_SPEC in the background, as if they had been started with `&'. If JOB_SPEC is not present, the shell's notion of the current job is used. Exit Status: Returns success unless job control is not enabled or an error occurs.

tcsh �� csh �̑g�ݍ��݃R�}���h�̈ꗗ��\������ɂ� builtins �R�}���h���g���܂��B

> builtins : @ alias alloc bg bindkey break breaksw builtins case cd chdir complete continue default dirs echo echotc else end endif endsw eval exec exit fg filetest foreach

���L�҂Ńt�@�C����T��

�t�@�C����T���Ƃ��ɕ֗��ȃR�}���h find �ɂ� ���L�҂��w�肵�ĒT���I�v�V����������܂��B

$ find . -user root

����ŏ��L�҂� root �ɂȂ��Ă���t�@�C����T�����Ƃ��ł��܂��B

�O���[�v���w�肷�邱�Ƃ��ł��܂��B

$ find . -group adm

���[�U�ƃO���[�v�𗼕��w�肷�邱�Ƃ��ł��܂��B

$ find . -user root -group adm

���[�U���폜����Ƃ��� ���̃��[�U�̃t�@�C�����c���Ă��Ȃ��� �T���Ƃ��ɕ֗��ł��B

wget �œr���Ŏ~�܂������ɍĊJ����

wget �Ń_�E�����[�h���Ă���Ƃ��� �r���Ŏ~�܂邱�Ƃ�����܂��B

$ wget http://example.com/images/cdrom.iso

--2011-11-01 22:38:49-- http://example.com/images/cdrom.iso

Connecting to 192.168.3.1:3128... connected.

Proxy request sent, awaiting response... 200 OK

Length: 717225984 (684M) [application/octet-stream]

Saving to: `cdrom.iso'

99% [========================================> ] 714,444,862 --.-K/s eta 2s

����ȂƂ��� -c �I�v�V������t���Ď��s���܂��B

$ wget -c http://example.com/images/cdrom.iso --2011-11-01 22:49:16-- http://example.com/images/cdrom.iso Connecting to 192.168.3.1:3128... connected. Proxy request sent, awaiting response... 206 Partial Content Length: 717225984 (684M), 2781122 (2.7M) remaining [application/octet-stream] Saving to: `cdrom.iso' 100%[+++++++++++++++++++++++++++++++++++++++>] 717,225,984 1.00M/s in 2.6s 2011-11-01 22:49:18 (1.00 MB/s) - `cdrom.iso' saved [717225984/717225984]

����őO�̑�������_�E�����[�h���邱�Ƃ��ł��܂��B

�A���������������� 1 �����ɂ��� tr �R�}���h

tr �R�}���h�ɂ� �A���������������� 1 �����ɂ��� -s �Ƃ����I�v�V����������܂��B

�Ⴆ�Ύ��̂悤�ɃX�y�[�X�������Ă���ꍇ

abcde fghij

tr �R�}���h���g���ΊȒP�ɃX�y�[�X�� 1 �ɂ��邱�Ƃ��ł��܂��B

abcde fghij

���̂悤�Ɏw�肵�܂��B

$ echo "abcde fghij" | tr -s [:space:] abcde fghij

[:space:]�́A�X�y�[�X��^�u�Ȃǂ����������N���X�ł��B

ls �̏o�͂��ȒP�ɉ��H�ł��܂��B �i�Ӗ��͂Ȃ��ł����j

$ ls -ltr | head | tr -s [:space:]

total 9498

drwx------ 2 root root 48 1970-01-01 09:00 gconfd-root

drwx---rwx 2 root hpusers 48 2006-09-09 16:03 mmcache

drwxr-xr-x 2 apache apache 48 2006-09-09 16:11 fcgi

drwx------ 2 root root 120 2006-09-27 12:15 YaST2-06402-9kTlAk

drwxr-xr-x 4 root root 96 2007-06-03 17:21 pear

drwx------ 3 root root 80 2007-07-06 19:09 spamd-4708-init

drwx------ 3 root root 80 2007-07-06 22:28 spamd-4426-init

drwx------ 2 root root 120 2009-01-15 09:46 YaST2-04662-jtfPyg

srwxrwxrwx 1 mysql mysql 0 2010-03-04 08:29 mysql.sock

�A������u���������v�� 1 �ɂ��邾���Ȃ̂� [:alpha:] �� �w�肷��Ǝ��̂悤�ɂȂ�܂��B

$ echo "aaabbccddaaa" | tr -s [:alpha:]

abcda

�v�������Ȃ��Ƃ��ɖ��ɗ����Ƃ�����܂��B

apt-get �Ńp�b�P�[�W���w�肵�ăA�b�v�f�[�g����

apt-get �� upgrade �� �C���X�g�[���ς݂̃p�b�P�[�W��S�ăA�b�v�f�[�g���܂��B

apt-get update �� �p�b�P�[�W�̃A�b�v�f�[�g�ł͂Ȃ��A �p�b�P�[�W���X�g�̃A�b�v�f�[�g�ł��B �w�肵���p�b�P�[�W���A�b�v�f�[�g����ɂ� ��₱�����ł��� install ���w�肵�܂��B

�C���X�g�[���ς݂� apache2 ���A�b�v�f�[�g���Ă݂܂��B